AI時代のエッジ戦略 - Fastly プロダクト責任者コンプトンが展望を語る

Fastlyは、LLMのAPI応答をキャッシュすることで、コスト削減と高速化を実現する「Fastly AI Accelerator」の提供を開始した。キップ・コンプトン最高プロダクト責任者(CPO)は、類似した質問への応答を再利用し、効率的な処理を可能にすると説明した。さらに、コンプトンは、エッジコンピューティングの利点を活かしたパーソナライズや、エッジにおけるGPUの経済性、セキュリティへの取り組みなど、FastlyのAI戦略について語った。

要約

Fastlyは、LLMのAPI応答をキャッシュすることで、コスト削減と高速化を実現する「Fastly AI Accelerator」の提供を開始した。キップ・コンプトン最高プロダクト責任者(CPO)は、類似した質問への応答を再利用し、効率的な処理を可能にすると説明した。さらに、コンプトンは、エッジコンピューティングの利点を活かしたパーソナライズや、エッジにおけるGPUの経済性、セキュリティへの取り組みなど、FastlyのAI戦略について語った。

Fastly AI Accelerator

10月6日に東京・原宿で開催された同社の年次イベントFastly Yamagoya2024のため来日した、コンプトンにFastly AI Acceleratorと同社のAI展開について聞いた。

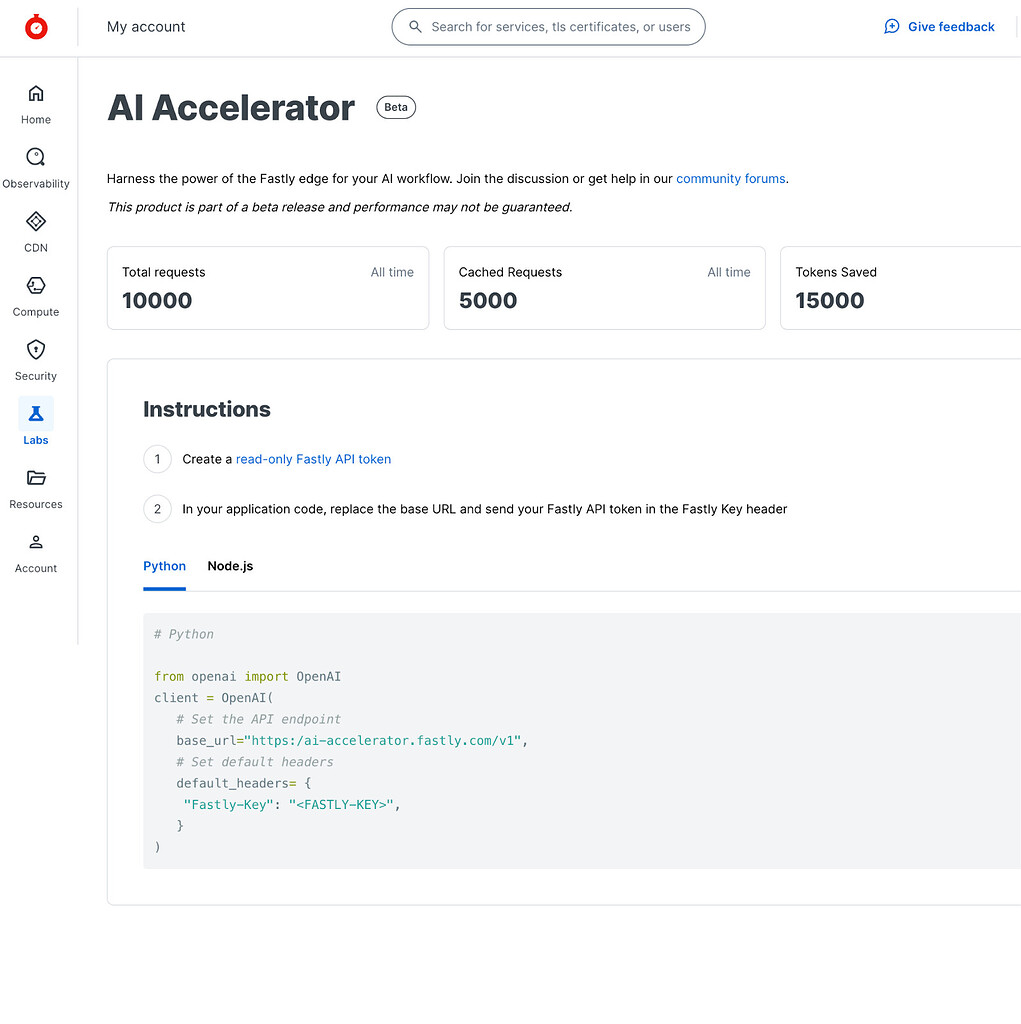

「大規模言語モデル(LLM)は『大きい』。OpenAIやGeminiを使うと都度都度費用がかかり、また、何か処理を依頼するたびに時間がかかる。ChatGPTのチャットを使ったことがある人ならわかると思うが、実際に時間がかかる」とコンプトンは言った。「APIの応答をキャッシュすることで、LLMに何度も同じ質問をする必要がなくなり、コストを削減できる。そして、より速いエクスペリエンスを提供する」

「私がこの製品のデモをするとき、多くの場合、キャッシュは0.5秒で応答することができるが、LLMでは完全な応答に6~8秒かかることも珍しくない。大きなスピードの違いだ」

「OpenAIのサポートから始め、私たちはその後Geminiのサポートを追加。ベータ版を使用している多くの人が、より多くのモデルのサポートを求めていたためだ」「ベータ版のリリースにより、実際にお客様にご利用いただく中で、我々は貴重な知見を得ることができた。すでにGeminiを加えるという拡張に成功し、また、お客様のユースケースに合わせてチューニングすることもできた」

Fastly AI Acceleratorは、パフォーマンス向上とコストを削減するために設計された、Open AI APIのためのセマンティック・キャッシュ・ソリューションであり、OpenAI Chat completion API のレスポンスをキャッシュする。その中核的な機能がセマンティック・キャッシングである。Fastlyは6月に「Fastly AI Accelerator」の提供開始を発表していた。

「何が質問されているかを判断するためにベクトルデータベースを使う。そして、その質問がどの程度似ているかを調べ、もし十分に似ていれば、マッチしているとみなし、キャッシュを利用する」

セマンティックキャッシュは、通常のキャッシュと同じように、過去の応答を再利用して、現在のリクエストに答える技術。違いは、どの応答を再利用するかを決める方法にある。通常のキャッシングでは、リクエストがURL、トークン、またはハッシュと完全に一致する場合にのみ、過去の応答を再利用する。一方、セマンティックキャッシュでは、AIの埋め込み(エンベディング)を活用することで、意味的に類似したリクエストに対する過去の応答を再利用できる。

「最も一般的なユースケースは、チャットボットを活用するカスタマーサポートのウェブサイト。バーチャルアシスタントを使用し、同じ質問がなされる度に料金が発生するようなウェブサイトであれば、大企業の従業員をサポートする社内向けサイトでも、社外向けのサイトでもその実装と使用コストを削減し、パフォーマンスを向上させることができる」「エッジを利用してより高いパフォーマンスと低コストを実現するというアイデアについては、私たちは他の分野でも行っている。これをAIにも持ち込んだ」

エッジサーバーにGPUを導入する可能性は?

エッジサーバーにGPUを配置するような未来はありうるか。「エッジでのモデルのトレーニングは想定していない。エッジで推論を実行した方が理にかなっている可能性がある。LLMはかなり大きいため、(レスポンスを)キャッシュする方が理にかなっていると考えている」

「現在、エッジでGPUを展開していない理由は2つある。第一にキャッシュできるため、そもそも使う必要がないということだ。キャッシュは効率的だ」

コンプトンは、動画のトランスコーディングはコストがかかるため、多くの顧客は一度実行してキャッシュし、繰り返し実行するのを避けたいと考えていると指摘した。例えば、4KのRAW映像から1080p 60 FPSや720p 30 FPSの動画を生成し、それをエッジにキャッシュする。データを保存しておく方が、都度送信するよりも安価なため、セントラルクラウドでトランスコーディングを行い、その後キャッシュすることになるのだという。

もう一つは、GPUの経済性がかなり急速に変化していることだ、と言った。「レンタル市場では、すでにかなり急激なコストの下降と上昇が見られたと思う。エッジは、セントラルクラウドとはまったく異なる場所だ。なぜなら、1つの場所にトラフィックが集中しないからだ。したがって、エッジにGPUを導入した場合、それらを十分に活用しながら、必要に応じてお客様がアクセスできるようにするのは困難だ」

「それがどうなるかは、これから推移を追ってみたい。すでに導入している処理能力で AI ユースケースをサポートできると確信している。大量の GPU を導入して使用率が低い場合、コスト構造に悪影響を及ぼし、他のお客様がそれを支払うことになるかもしれない。GPUは初期費用と消費電力が非常に高額だ。これまでのユースケースでは、汎用プロセッサでサポートできた」

ただ、準備はできているという。「我々がエッジサーバーを配置している場所では、電力と冷却の面で GPU を追加するための余裕を持たせている。エッジでの有用性が明らかになるまでその技術を展開したくはない。キャッシュが非常に効率的であるためだ。また、たとえば、ビデオの低解像度バージョンを生成する場合は、高解像度バージョンがエッジに必要となる。この場合、データストアに 30 ~ 40% のストレージを追加すれば、ユーザーはより高いパフォーマンスを得ることができる」。

パーソナライズされたレコメンドをエッジで行う

コンプトンは、メトロポリタン美術館のレコメンデーション(推薦)をエッジサーバーで活用した例に言及した。Fastlyは、ユーザーに近いエッジサーバーで推薦処理を実行し、高速なレコメンドを実現した。チームは特殊なアルゴリズムを用いて、コレクションデータを効率的に表現する検索を構築。さらに、検索のコストを、エッジサーバーのパフォーマンス内に収まるように工夫を施した。

「エッジでコンテンツをパーソナライズすることには、大きな合理性がある。なぜなら、ユーザーはパフォーマンスを求めている。パーソナライズされた体験を提供するウェブサイトでは、ユーザーの興味を推測している。過去の購入履歴や、応援しているスポーツチームなどをもとにしている。ユーザーによって表示されるページは異なるものになる」

「私たちは(メトロポリタン美術館の)すべての画像をエッジにキャッシュした。だから、(もし東京でそのサイトを見たとき)あたかも東京のデータセンターからサーブされたかのような速さの体験を味わえる。先ほど確認したところ、(取材場所の都心に対して)最も近いPOP(Point of Presence)から6ミリ秒で配信できる。パーソナライゼーションを計算するためには、クラウドにコンタクトするのは避けたいものだ」

「私たちは、お客様が妥協することなく最高のエクスペリエンスを提供できるようにすることについて話し合った。私たちにとって、それは設計段階から高速でセキュアであることを意味する」

CDNが果たす役割

現在、AIコンピューティングはデータセンターに集中しているが、オンデバイスAIがテストされている。FastlyのようなCDNのプレイヤーはこの中間に属する。AIコンピューティングにおいてCDNはどのようなポジションを占めるのか?

「私はAppleの戦略が際立っていると考えている。Apple Intelligenceは、アーキテクチャについてかなり公開されている。そして、最新の携帯電話にはAIモデルが搭載されているが、クラウドではより大きなモデルが利用できるようになっている。我々は今後、(デバイスとクラウドにまたがる)ハイブリッドモデルを目にすることになるだろう」

「私たちは、GoogleやAppleと協力してプライバシー保護に取り組んでいる。具体的には、GoogleのプライバシーサンドボックスとAppleのプライベートリレーを連携させているのだ。これにより、ユーザーはプライバシーを確保しながら、インターネットを利用することができる。デバイスでのモデルの実行ももちろん行われる可能性があるが、最も洗練されたモデルは、データセンターで実行され続けることになるだろう」

「どちらにも長所と短所があるでしょう。そして、Appleはその両方をどのように併用し、どのように管理していくのかを明確に示していると思う。より大きなモデルをデータセンターで集中的に利用する。私はそれが他の多くの企業が行き着く場所だと思う」

ところで、もうひとつ興味深い例がある、という。「トレーニング・データセットを高速に処理し、複数のクラウドの複数の場所でモデルのトレーニングに使いたいというお客様がいる。一部のお客様は、データ設定をライセンス供与して、他の人がモデルをトレーニングできるようにしている。そのため、大量のデータに非常に高速にアクセスする必要があり、CDN がそれを提供するのに適している。

「非常に大きな画像ライブラリがあり、さまざまな環境で複数のモデルをトレーニングしたい場合、CDN はそれを処理する優れた方法だ。CDNはAI の世界で依然として重要な問題の解決に役立つ」

「パフォーマンスは依然として重要だ。セキュリティもコスト効率も必要で、グローバルに拡張できることも必要だ。そのため、AI の実践者は、他の開発者と同じように、作業をサポートするために Fastly サービスを使い始めていることがよくある」

エッジにおけるAI の将来

エッジにおけるAI の将来とはどのようなものか?「セキュリティ、パフォーマンス、コスト、パーソナライゼーションは依然として重要だと考えている。私たちは、開発者と、お客様と協力して継続的にソリューションを構築し、改善することを重視している」

「Fastly AI Acceleratorは、お客様が抱える『より速く、より安く』という課題から生まれたものだ。エンジニアも、より速く、より安く開発できればと考えているのではないだろうか。 私たちが提供するFastly AI Acceleratorは、お客様のニーズに応えるだけでなく、エンジニアの開発効率向上にも貢献できると信じている」

「私たちは先を見据えて開発者にとても優しいプラットフォームを提供している。Fastly AI Accelerator のようなソリューションをプラットフォームに追加することで、お客様がFastlyのプラットフォームを活用して課題解決を実現する支援に注力している」