感情認識AIは思想警察になる?

感情認識AIが有効な科学に基づいていると仮定すれば、肯定的な使用例があるかもしれないが、ジョージ・オーウェル的な「思想警察」へとつながるリスクを孕んでいることは否定できない。

感情認識AIが有効な科学に基づいていると仮定すれば、肯定的な使用例があるかもしれないが、ジョージ・オーウェル的な「思想警察」へとつながるリスクを孕んでいることは否定できない。

テクノロジー業界のアナリスト企業であるAIMultipleが最近発表したブログによると、感情認識AIは、「コンピュータやシステムが人間の感情や感覚を識別、処理、シミュレーションできるようにする」新しい技術であると述べている。

このような技術の利用は、ますます広がっている。例えば韓国では、就職面接で感情認識AIの利用が一般的になっており、就職活動支援者が顧客にAI面接を受ける練習をさせることもしばしばあるそうだ。スタートアップEmotionTracは、弁護士向けに、リアルタイムで表情を分析し、どのような主張が陪審員候補に響くかを把握するソフトウェアを販売している。テルアビブ大学は、顔の筋肉分析によって嘘を検出する技術を開発し、73%の精度を主張した。Appleは「顔の表情および/または感情に反応して知的エージェントの動作を変更する」ための特許を取得した。

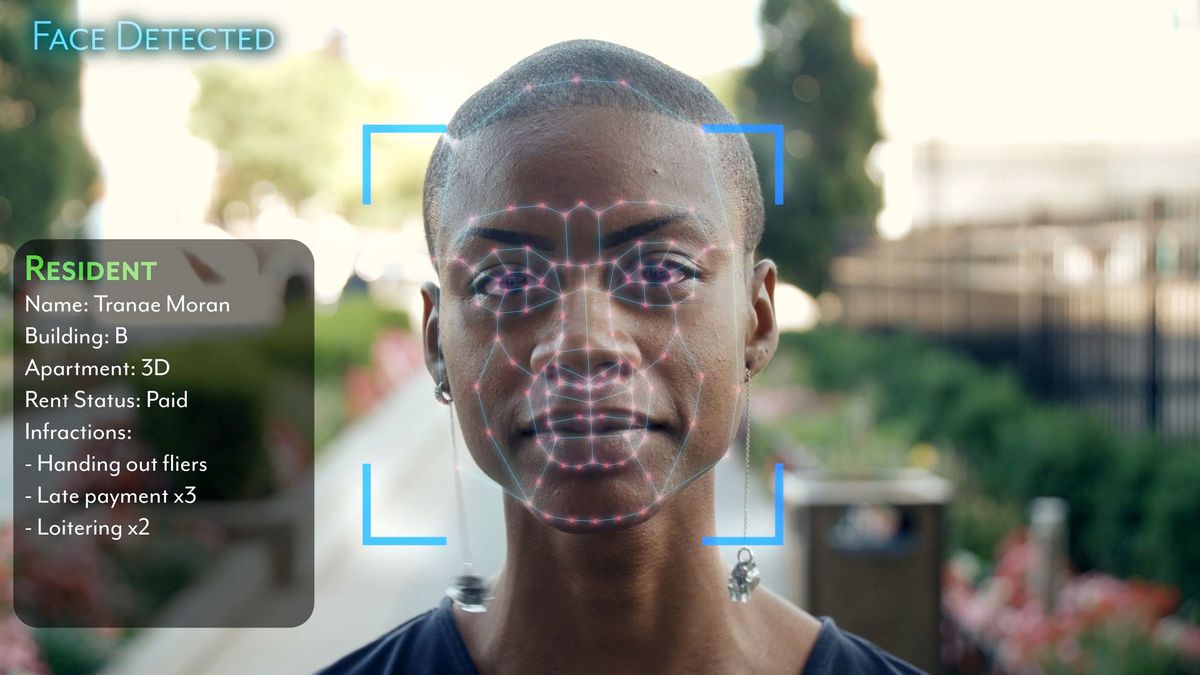

幸いなことに、顔認識技術は社会的に注目されている。最近Netflixで公開された受賞作「Coded Bias」は、多くの顔認識技術が肌の色の濃い人の顔を正確に検出できないことを発見したことを記録している。また、顔認識の学習に用いられる最大かつ最も重要なデータセットの1つであるImageNetを管理する研究チームは、最近、プライバシーに関する懸念に対応するため、150万枚の画像にぼかしを入れることを余儀なくされた。

しかし、感情AIは曖昧さと論争に満ちている。特に、顔の表情は文脈や文化によって大きく異なることが研究者によって明らかにされているからだ。また、顔の動きは、感情的な意味を表す一貫した信号というにはあまりに多様であるという、かなりの証拠がある。

感情認識AIの多くは「あらゆる人が同じように表現する」という「基本感情」の理論に基づいている。しかし、この説は次第に否定されつつある。人類学の研究によると、文化や社会によって感情の表現が異なることが分かっている。2019年、Association for Psychological Scienceは証拠のレビューを行い、人の感情の状態が顔の動きから容易に推測できるという一般的な仮定には、科学的な裏付けがないと結論づけた。

AI倫理学者のケイト・クロフォードは根底からこのテクノロジーを疑っている。クロフォードは顔の表情が人の感情を表すという良い証拠はないと結論付けている。したがって、感情認識AIに基づいて行われる判断は不確実性を孕んでいる可能性がある。

この懸念により、少なくとも一部の企業は感情AIの開発・配備から手を引いている。マイクロソフトは最近、より有益で公平な結果を確保し、信頼できるAIを育成するために、AIシステムの構築方法の指針となる「責任あるAI基準」の枠組みを更新した。このフレームワークを用いたAI製品やサービスの社内レビューの結果の1つは、Face API内の「感情状態やアイデンティティ属性を推論する」機能の「削除」である。同社によると、この決定は、特に人口統計やユースケースにわたって、外見から感情を推論する方法について専門家のコンセンサスが得られていないことと、プライバシーに関する懸念に基づくものだという。

英国では、この技術の警察での使用に関して法的な問題に直面している。欧州連合(EU)では、40以上の市民団体からなる連合が、顔認識技術の全面的な禁止を要求している。

同様の感情認識AI技術は、数年前から生産性向上のために企業で利用されている。Insiderの記事では、中国の雇用主が「感情監視技術」を使って、従業員の配置や休憩などのワークフローを変更し、生産性と利益を向上させていると報じている。

この技術に関心を寄せているのは企業だけではありません。最近発表された英インディペンデントのレポートによると、中国の合肥総合国家科学センター人工知能研究所は、顔の表情や脳波を読み取って「思想・政治教育の受容度を見分ける」AIプログラムを作成した。被験者に共産党に関するビデオを見せ、AIプログラムはそのデータを収集・処理した。そして、被験者がより多くの政治教育を必要としているかどうかを示すスコアを返し、十分な忠誠心を持っているかどうかを評価した。採点には被験者の「党に感謝し、党の言うことを聞き、党に従うという決意」が含まれていたという。

ケンブリッジ大学人類学リサーチアソシエイトのアレクサ・ハガティとユニバーシティカレッジロンドン(UCL)市民社会科学リサーチフェローのアレクサンドラ・アルバートは、感情認識AIがすべての人の感情を正確に読み取ることができるように設計されたとしても、私たちは生活の中でこのような密接な監視を望むだろうか、という関連した疑問を投げかけている。

二人は、他の顔認識技術と同様、ERTには人種的なバイアスがかかっている、と主張し、ある研究では、黒人の顔は白人の顔に比べ、表情に関係なく怒っているように見えるという結果が出ていることに言及している。