AIチップの需給逼迫は続く:技術と生産能力の制約はかなりタフだ

AIに対する世界的な需要は、AIチップのサプライチェーンの制約を明らかにした。要素技術と生産能力に容易ではない課題があり、需給逼迫は「少なくとも」来年までは解決しない模様だ。

AIに対する世界的な需要は、AIチップのサプライチェーンの制約を明らかにした。要素技術と生産能力に容易ではない課題があり、需給逼迫は「少なくとも」来年までは解決しない模様だ。

この供給不足は、AI業界の大手企業を含む大小さまざまな企業に影響を及ぼしている。アナリストは、この状況はあと1年以上続くと予測している。AIチップとその周辺製品は、データセンターに対する様々な投資をかき集め、他の製品への需要を圧迫している、とフィナンシャル・タイムズ(FT)はリサーチ会社Couterpointの調査を引用した。

FTの報道によると、NVIDIAは2024年にAIチップ「H100」の生産量を3倍に増やす計画だ。同社が引用したNVIDIAに近い3人の関係者によると、世界で最も価値のあるチップメーカーは現在、同社の最高級AIプロセッサーH100の生産量を少なくとも3倍に増やす計画で、2024年のH100の出荷台数は150万~200万台となり、今年予想される50万台から大幅に増加する。

NVIDIAの最先端AIプロセッサを独占的に製造している台湾積体電路製造(TSMC)は先月、AIサーバー用チップの需要は今後5年間、毎年50%近く成長すると予測した。

リサーチ会社Gartnerはもう少し穏やかな予想を立てている。同社の報告によると、AIチップの市場は、年率20%以上で成長している。同市場アナリストは、AIチップ市場は2023年には前年比20.9%増の534億ドルに達し、2024年には前年比25.6%増の671億ドルに達すると予測した。Gartnerのバイスプレジデントアナリスト、Alan Priestleyは、 2027年には、AIチップの市場規模は2023年の市場規模の2倍以上となり、1,194億ドルに達すると予想した。

先端技術が制約に

AIサーバー市場の成長を鈍化させているサプライチェーンの制約がある。主要なものは、アドバンスドパッケージ(*1)という半導体の3D化を支える技術である。なかでも、2012年にTSMCによって開発されたCoWoS(Chip on Wafer on Substrate)技術の能力が、業界が供給できるキャパシティの上限を形成している。

CoWoSはチップを複数枚重ねて接続する技術で、 低いコストで最高の相互接続と最大のパッケージサイズを提供することができる。

TSMCは7月、台湾西部に900億台湾ドル(4,100億円)を投資し、CoWoSを含むアドバンスドパッケージを行う工場を建設する、と発表した。建設は2024年後半に開始され、2027年に量産が開始される予定だ。TSMCの顧客であるNVIDIAやAMDのようなAI向け半導体の生産には欠かせない。

台湾メディアDIGITIMESによると、TSMCは2024年末までにCoWoSの能力を2倍以上に拡大する予定だ。 TSMCは、CoWoS能力を現在の月産8,000枚から年末までに月産11,000枚に、さらに2024年末までに約20,000枚に拡大する意向であると報じられている。それでもNVIDIAはその時点で同ファウンドリーが持つと予想される能力の半分を消費することになるという。一方、AMDも来年に向けてCoWoSの追加容量を予約しようとしているようだ。

このDIGITIMESの報道によると、TSMCは、毎月約8,000枚のCoWoSウェハーを処理できるが、そのうち70〜80%はNvidiaとAMDが占めている。ブロードコムが10%で第3位、残りは他のファブレス・チップ設計者20社に分散されている。

AMDの「Instinct MI300」やNVIDIAの「H100」のような非常に複雑な設計の採用を促進しているのは、現状はAIがほとんどだが、5G、ハイパフォーマンス・コンピューティング(HPC)という分野でも需要が見込まれている。

米国と日本はTSMCに対し、CoWoSやその他の高度なパッケージング施設を設置するよう積極的に誘致している、と台湾メディアDIGITIMESが報じた。

AIコンピューティングに必須の高帯域幅のメモリも制約に

膨大な並列計算を実行するAI向けGPUにとって、メモリ帯域幅は重要な要素だ(*2)。AIモデルのパラメータ数が指数関数的に増加しているため、AIチップの性能では、メモリから学習・推論データを保存・取得する能力がボトルネックになりうる。

この問題に対処するため、最先端のデータセンター向けGPUはHBM(High Bandwidth Memory:高帯域幅メモリー、直訳)とパッケージ化されている。

HBMの主な課題は、メモリのパッケージングと積層であり、これは韓国半導体企業SKハイニックスが得意とする。SKハイニックスは2022年6月にHBM3の生産を開始し、現在、最新世代の「HBM3」を大量に出荷している唯一のサプライヤーであり、市場シェアは95%以上だ。この事実上の一社独占が、供給キャパシティの柔軟性を市場から奪っている。

一応、追走者はいる。サムスンは2023年後半にHBM3を出荷する予定だ。だが、マイクロンは完全に遅れている。

HBMと前述のCoWoSは相補的である。HBMは、たくさんのチップと接続する必要があるため、従来のパッケージングではうまくいかず、CoWoSを必要とする。現在、ほぼすべてのHBMシステムがCoWoSを使用してパッケージされており、すべての高度なAIチップがHBMを使用しているため、事実上すべての最先端AIチップはTSMCのCoWoSによってパッケージされていることになる。

脚注

*1:アドバンスドパッケージ(Advanced Package)技術とは、複数の半導体を水平方向および垂直方向にも接続するヘテロジニアス・インテグレーション(Heterogeneous Integration)技術。より小さな半導体により多くのトランジスタを集積でき、それぞれの性能を上回るより強力な性能を実現する。

*2:推論とトレーニングのワークロードはメモリを大量に消費する。AIモデルのパラメータ数が指数関数的に増加しているため、モデル・サイズは重みだけでテラバイトにまで膨れ上がっている。

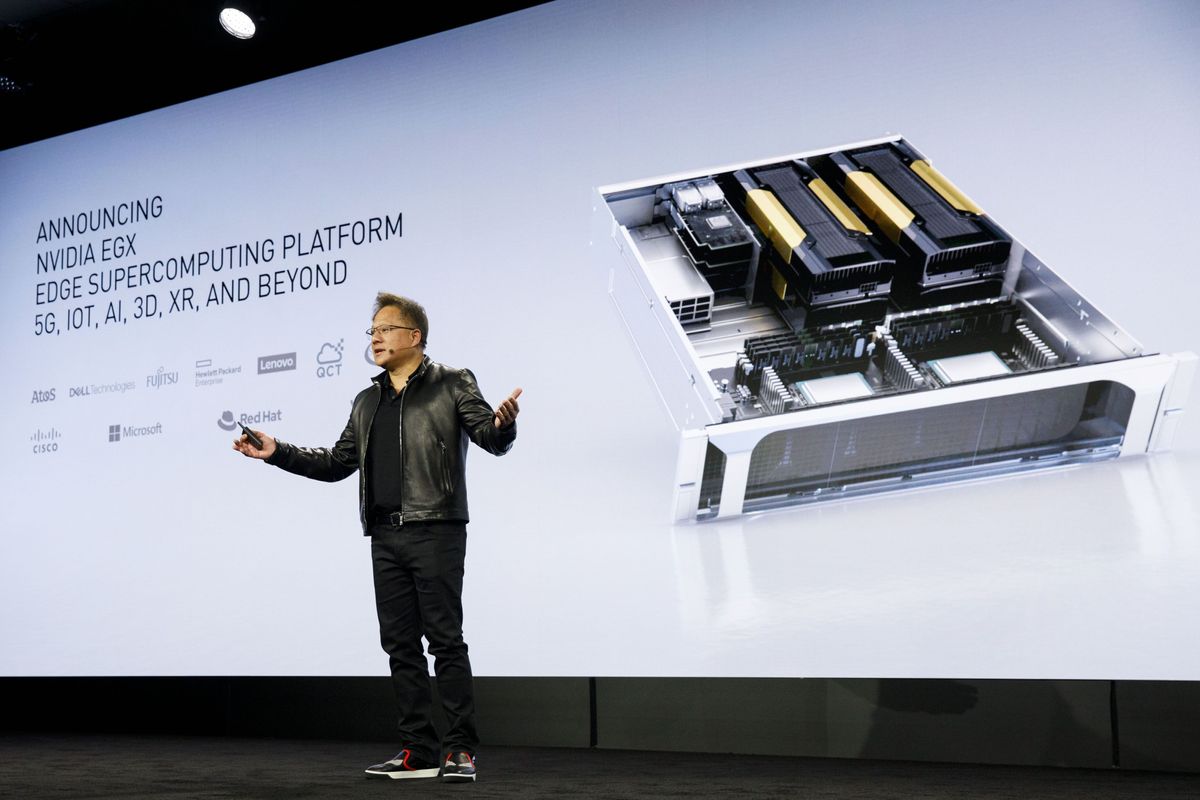

2019年10月21日(月)、米国カリフォルニア州ロサンゼルスで開催されたMobile World Congress Americasの同社イベントにおいて、EGX Edge Supercomputing Platformを発表するエヌビディア・コーポレーションの社長兼最高経営責任者(CEO)Jen-Hsun Huang氏。この会議には、世界中のモバイル通信事業者、デバイスメーカー、テクノロジープロバイダー、ベンダー、コンテンツオーナーを代表する著名な経営幹部が参加しています。写真家 パトリック・T・ファロン/ブルームバーグ