AIシステムがミュージシャンの無音動画から音楽を推測

MITとMIT-IBMワトソンAIラボの研究者たちは、楽器を演奏するミュージシャンの無音のビデオから「もっともらしい」音楽を生成するAIシステム「Foley Music」を紹介した。このシステムは様々な音楽演奏に対応しており、聞いていて気持ちの良い音楽を生成するという点で既存のシステムを凌駕しているという。

要点

MITとMIT-IBMワトソンAIラボの研究者たちは、欧州コンピュータビジョン会議に採択された研究の中で、楽器を演奏するミュージシャンの無音のビデオから「もっともらしい」音楽を生成することができるAIシステム「Foley Music」を紹介している。彼らによると、このシステムは様々な音楽演奏に対応しており、聞いていて気持ちの良い音楽を生成するという点で「いくつかの」既存のシステムを凌駕しているという。

体の動きから音楽を推測することができるAIモデルは、ビデオに自動的に効果音を追加することから、仮想現実の中で没入感のある体験を作成するために、さまざまなアプリケーションの基盤として役立つ可能性があると研究者たちは考えている。認知心理学の研究では、人間がこのスキルを持っていることが示唆されている - 幼い子供でさえ、彼らが聞くものは、例えば、人が話すのを見てから受け取る信号によって影響を受けると報告している。

Foley Musicは、映像から人の身体(計25点)と指(計21点)の2次元キーポイントを中間的な視覚表現として抽出し、身体や手の動きをモデル化します。音楽には、各音のタイミングや大きさを符号化したMIDI表現を採用している。キーポイントとMIDIイベント(約500個)を与えられた「グラフ変換器」モジュールは、動きと音楽を関連付けるためのマッピング関数を学習し、長期的な関係性をキャプチャして、アコーディオン、ベース、ファゴット、チェロ、ギター、ピアノ、チューバ、ウクレレ、バイオリンのクリップを作成する。

MIDIイベントはシステムによって音楽にレンダリングされないが、研究者は、それらが標準的なシンセサイザーにインポートすることができることに注意してください。研究チームは、これを自動的に行うためのニューラルシンセサイザーの訓練については、今後の研究に委ねている。

実験では、研究者は11のカテゴリに属する1,000の音楽パフォーマンスビデオを含む3つのデータセット上でFoley音楽を訓練した。URMPは、スタジオで録音された高品質の多楽器のビデオコーパスであり、録音された各ビデオにはMIDIファイルが提供されている。

研究者たちは、訓練されたFoley Musicシステムに450本の動画のMIDIクリップを生成させた。その後、Amazon Mechanical Turkのボランティアに、これらのクリップのうち50個を4つのカテゴリに分けて評価するというリスニング調査を実施した。

- 正しさ。 生成された曲が動画コンテンツにどれだけ関連しているか。

- ノイズ。 どの曲が最もノイズが少なかったか。

- 同期性。 どの曲が動画コンテンツと最も時間的に一致していたか。

- 総合的。 どの曲を聴きたいと思ったか

評価者は、Foley Musicが生成した音楽は、他のベースラインシステムに比べて、実際の録音物と区別しにくいことを発見したと報告している。さらに、MIDIイベント表現は、音質、セマンティック・アライメント、時間的同期を改善するのに役立つようだ。

その結果、身体のキーポイントとMIDI表現によって、視覚信号と音楽信号の間の相関関係が十分に確立されることが示された。さらに、我々のフレームワークを簡単に拡張して、MIDI表現を使って異なるスタイルの音楽を生成できることを示しています」と共著者は書いています。「私たちの研究は、中間的なボディキーポイントとMIDIイベント表現を用いて、映像と音楽のつながりを研究するための将来の研究を切り開くものと期待しています」。

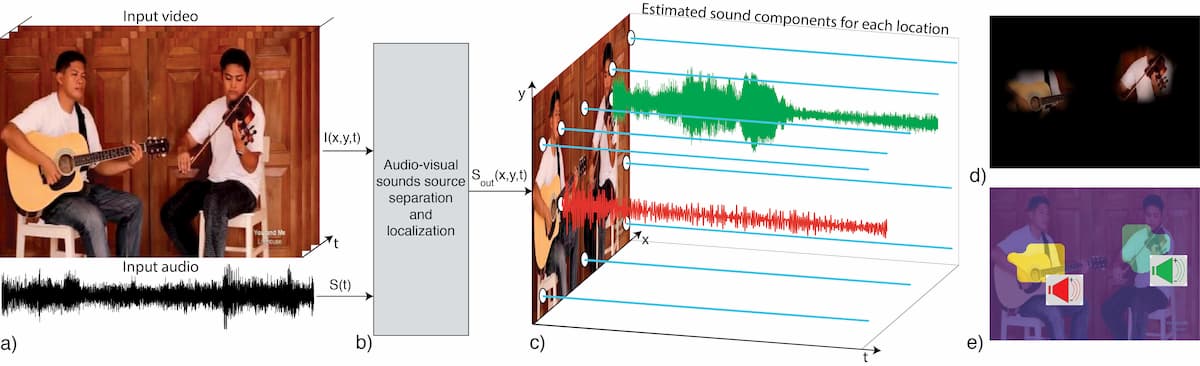

Foley Musicは、MITのコンピュータサイエンス・人工知能研究所(CSAIL)の研究者が、AIを使って楽器の音を区別して分離するシステム「Pixel Player」を詳細に発表してから1年後に発表されたもの。完全に訓練されたPixelPlayerは、入力としてビデオを与えられると、付随する音声を分割して音源を識別し、画像内の各ピクセルの音量を計算して「空間的に定位」する、つまりクリップ内の類似した音波を発生させる領域を識別する。

参考文献

- Chuang Gan et al. Foley Music: Learning to Generate Music from Videos. arXiv. 2007.10984.

Photo by Gabriel Gurrola on Unsplash