Amazon、クラウドでの機械学習トレーニング用カスタムチップ「Trainium」を発表

Amazonは1日、AWS Trainiumを発表した。これは、同社が費用対効果の高い機械学習モデルのトレーニングをクラウド上で提供するためにカスタム設計されたチップ。これは、インテルの新しいHabana Gaudiプロセッサを搭載したHabana GaudiベースのAmazon Elastic Compute Cloud (EC2) インスタンスが、機械学習トレーニングのために特別に構築されるのに先駆けて発表されたものである。

Amazonは1日、AWS Trainiumを発表した。これは、同社が費用対効果の高い機械学習モデルのトレーニングをクラウド上で提供するためにカスタム設計されたチップ。これは、インテルの新しいHabana Gaudiプロセッサを搭載したHabana GaudiベースのAmazon Elastic Compute Cloud (EC2) インスタンスが、機械学習トレーニングのために特別に構築されるのに先駆けて発表されたものである。

AWSのCEOであるAndy Jassyは、Amazonのre:Inventカンファレンスでの基調講演の中で、「機械学習トレーニングの価格性能を押し上げ続けたいと考えているので、独自のチップに投資しなければならないことはわかっている」と述べた。「AWSには、チップのイノベーションと相まって、比類のないインスタンスの配列がある」。

Amazonは、Trainiumがクラウド上の機械学習インスタンスの中で最もテラフロップ数が多いと主張している。Amazonは、標準的なAWS GPUインスタンスと比較して、スループットが30%高く、コストパーイナーシャが45%低いと見積もっている。

Trainiumが2021年後半にEC2インスタンスとして、またAmazonのフルマネージド機械学習開発プラットフォームであるSageMakerで利用できるようになると、GoogleのTensorFlow、FacebookのPyTorch、MxNetなどの一般的なフレームワークをサポートすることになる。さらにAmazonは、機械学習推論のための同社のクラウドホスト型チップであるInferentiaと同じNeuron SDKを使用すると述べている。

「Inferentiaは、MLインフラストラクチャコストの最大90%を占める推論コストに対応していましたが、多くの開発チームは、固定のMLトレーニング予算によって制限されている」とAWSはブログ記事で書いている。「これでは、モデルやアプリケーションを改善するために必要なトレーニングの範囲や頻度が制限されてしまいる。AWS Trainiumは、クラウド上でMLトレーニングのための最高のパフォーマンスと低コストを提供することで、この課題に対応している。TrainiumとInferentiaの両方を利用することで、顧客はトレーニングワークロードのスケーリングから高速推論の展開まで、エンドツーエンドでMLコンピュートを利用できるようになる」

ベンチマーク結果がないため、Trainiumの性能がGoogle Cloud PlatformでホストされているGoogleのテンソルプロセッシングユニット(TPU)と比較してどうかは不明だ。Googleによると、第4世代のTPUは、第3世代のTPUの2倍以上のマトリクス乗算テラフロップスを提供するという。

機械学習の導入は、高価なハードウェアの必要性によって制約を受けてきた。実際、MITのリサーチサイエンティストのニール・トンプソンらによる報告書は、機械学習が計算限界に近づいている可能性があることを示唆している。

OpenAIは、GPT-3言語モデルの訓練に1200万ドルを費やしている。Googleは、11の自然言語処理タスクのために最先端の技術を再定義した双方向変換モデルであるBERTの訓練に推定6,912ドルを費やしたと報告されている。

アマゾンは、企業での需要が高まるにつれ、AIや機械学習のトレーニングや推論サービスへの傾倒が進んでいる。ある推計によると、世界の機械学習市場は2017年に15億8000万ドルと評価され、2024年には208億3000万ドルに達すると予測されている。

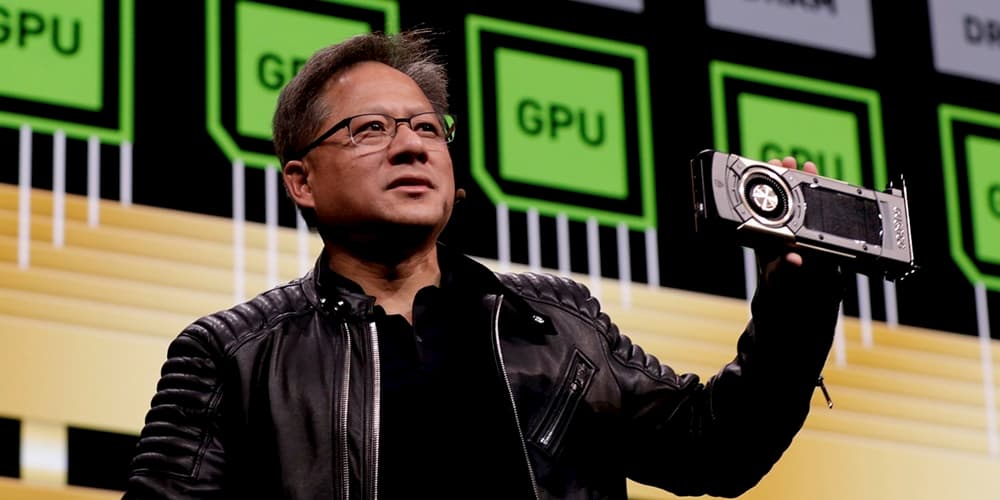

Amazonは11月、AlexaとRekognitionのためのコンピューティングの一部をInferentiaを搭載したインスタンスに移行したと発表し、Nvidiaのチップから離れながら、作業を高速化して安価にすることを目指していた。当時、同社はAlexaの一部の作業をInferentiaに移行したことで、レイテンシが25%向上し、コストが30%削減されたと主張していた。