計算資源がディープラーニングの制約に

ディープラーニングの進歩は計算能力の向上に大きく依存していることを示している。この依存度を考慮すると、現在の路線での進歩は急速に経済的、技術的、環境的に持続不可能になる可能性がある。継続的な進歩には、劇的に計算効率の高い方法が必要となり、ディープラーニングの改善、他の機械学習方法への移行からもたらされる。

要点

ディープラーニングの進歩は計算資源の向上に大きく依存していることを示している。この依存度を考慮すると、現在の路線での進歩は急速に経済的、技術的、環境的に持続不可能になってきている可能性がある。したがって、これらのアプリケーションの継続的な進歩には、劇的に計算効率の高い方法が必要となり、それはディープラーニングの改善、他の機械学習方法への移行からもたらされないといけない。

果てのない軍拡競争

ディープラーニングの最近の歴史は、囲碁の対局で人間に勝利したことから、画像認識、音声認識、翻訳、その他のタスクで世界をリードするパフォーマンスを達成したことで輝かしいものとなっている。近年の機械学習の進歩は急速で目もくらむようなもので、巧妙なゲームをプレイするプログラム、気配りのできるパーソナルアシスタント、交通量の多い道路を自分でナビゲートする車などを提供してくれている。しかし、このような進歩は、これまで以上に多くのコンピューティングリソースを問題に投入することに依存している。

MITのリサーチサイエンティストのニール・トンプソンとその同僚たちは、新しい研究論文の中で、これらの進歩を継続するためには、同じ速度でコンピューティング・パワーを増加させることは不可能であるか、あるいはすぐに不可能になるだろうと主張している。これは、コンピュータビジョン、翻訳、言語理解などの分野のさらなる進歩を危うくする可能性がある。

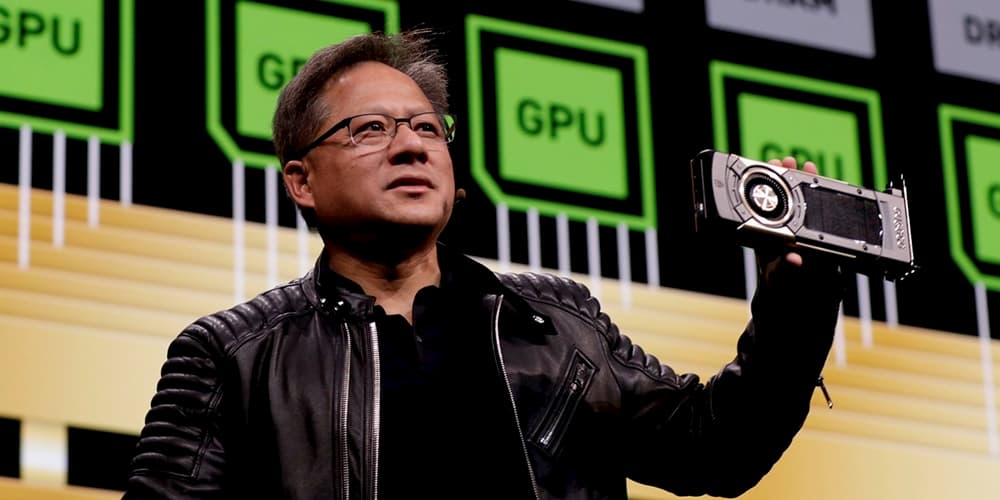

AIの計算に対する貪欲さは、この10年で著しく高まっている。ディープラーニングブームが始まった2012年、トロント大学のチームは、2つのGPUを使って、5日間かけて画期的な画像認識アルゴリズムを作成した。2019年には、グーグルとカーネギーメロン大学の研究者が、より現代的な画像認識アルゴリズムを開発するのに6日間と約1,000個のドメイン固有アーキテクチャのTPU(テンサー・プロセッシングユニット)を使った。昨年、Googleのチームが開発した翻訳アルゴリズムでは、大まかに言って12,000個のTPUを1週間稼働させる必要があった。これだけのコンピュータパワーをクラウド経由で借りるには、300万ドルもの費用がかかるとの試算もある。

他の研究者も、計算量の要求の高まりを指摘している。FacebookのAI研究所の所長であるJérôme Pesentiは2019年、AI研究者がこの計算量不足の影響を感じ始めていると語った。「機械学習研究に投入する計算量で夜も眠れないと言っていい。GoogleやFacebookのような計算量を持つ企業が供給量のピークにすでに到達してしまった」。最近の講演や論文では、特に大規模で最先端のAIプロジェクトに取り組んでいる研究者が、コストが高いため、複数のアルゴリズム設計をテストしたり、実験を再実行したりすることができないと不満を言い始めている、という。

GPUベース(後のASICベース)のディープラーニングの導入により、ディープラーニングの普及が進んだ。しかし、最先端のシステムで使われている計算能力の量は、2012年から2019年まで年率約10倍とさらに急速に成長している。これに対し、GPUに移行したことによる全体的な改善は約35倍であり、ニューラルネットワークのトレーニング効率の向上などもほんの小さな寄与を与えただけだ。つまり、機械学習は概して大量のマシンを投入することで、事態を解決してきた、と言える状況だろう。

トンプソンらは、ディープラーニングの多くの分野において、モデルの学習の進歩は、使用される計算能力の大幅な増加に依存している、と結論づけている。性能向上のための計算能力への依存はディープラーニングに限ったことではなく、気象予測や石油探査などの他の分野でも見られる。しかし、ディープラーニングの分野では、システムのコストが大幅に増加しており、現在では多くの最先端モデルが世界最大級のコンピュータシステムで実行されている。

トンプソンらは、巧妙な新しいアルゴリズムがなければ、ディープラーニングの限界が複数の分野での進歩を遅らせ、コンピュータが人間の仕事を置き換える速度に影響を与える可能性があると考えている。

この研究では、トンプソンと彼の共著者は、新しいアルゴリズムを概説した1,000以上のAI研究論文を調べた。すべての論文が計算要件を詳述しているわけではないが、進歩のコストを把握するには十分だった。その歴史は、同じ方法でこれ以上の進歩を遂げることは不可能に近いことを示唆している。

たとえば、英語からフランス語への機械翻訳アルゴリズムの性能を向上させて、現在の50%ではなく10%のミスしかしないようにするには、より多くの計算能力だけに頼ろうとすると、10億倍の10億倍の計算能力の驚異的な増加が必要になる。この論文は、近日中にarXivに投稿される予定だが、まだ査読を受けたり、ジャーナルに掲載されたりしていない。

より強力なチップと「新しい機械学習」があれば…

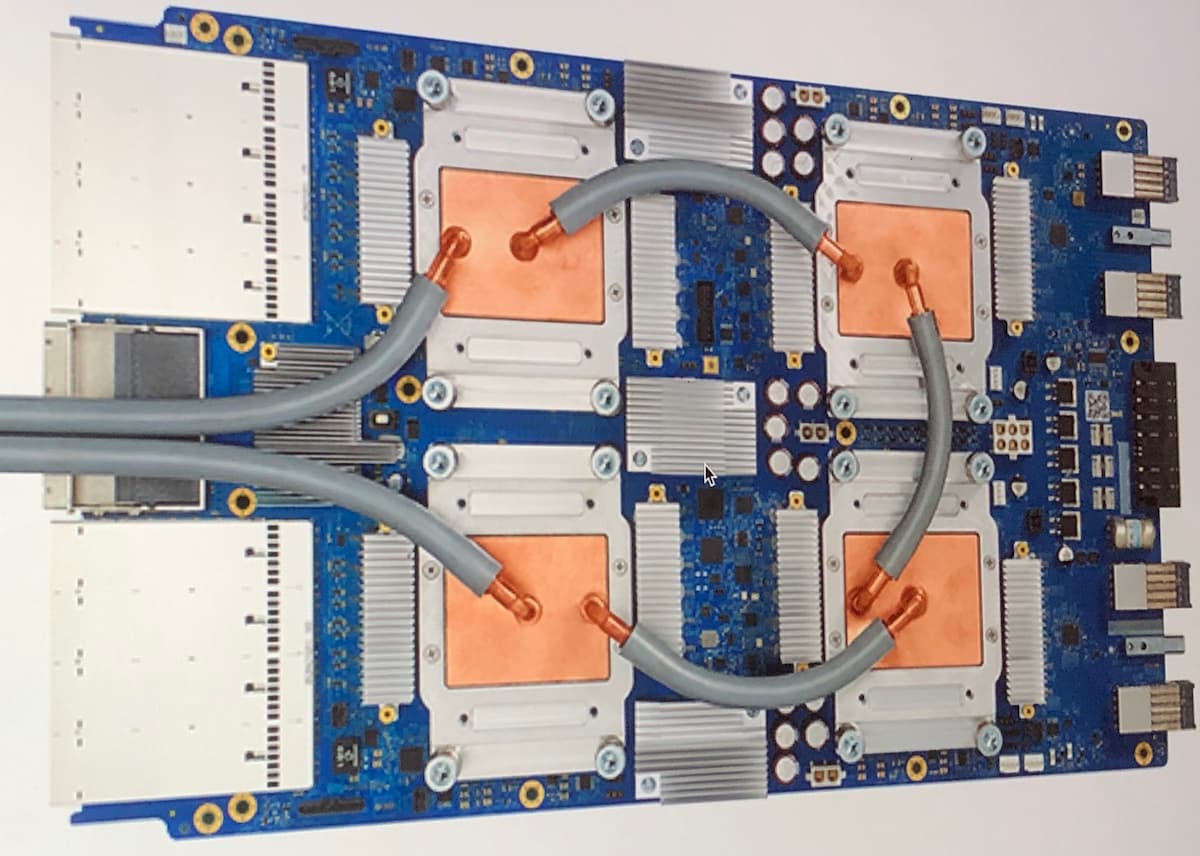

この状況は、より強力なチップとより効率的なソフトウェアによって覆される可能性がある。チップ部品の小型化に端を発した進歩は、原子レベルの製造という課題にもかかわらず続いている。一方、ドメイン固有アーキテクチャと呼ばれる特定の用途に専念したAIチップは、深層学習計算をより効率的に実行することができる。

2010年代の大部分は、より効率的なハードウェア・プラットフォームへの移行が、 コンピューティング・パワーを向上させる主な要因だった。ディープラーニングの場合、これらには主にGPUとTPUの実装が含まれていたが、最近ではFPGAや他のASICも含まれるようになってきている。基本的に、これらのアプローチはすべて、特殊化の効率化のためにコンピューティング・プラットフォームの汎用性を犠牲にしている。長期的な視野に立てば、量子コンピューティングは、計算能力が指数関数的に持続的に増加する可能性があるため、おそらく最も長期的なアップサイドを持つアプローチだ。

計算の複雑さを軽減することも重要なアプローチとトンプソンらは考えている。一連の研究では、主に訓練されたニューラルネットワークを利用して、予測タスクで使用するのに必要な計算量が少なくなるように、ネットワーク内の接続を圧縮することに焦点を当てている。これまでのところ、これらのアプローチは、この分野の全体的な計算量の桁数の増加に比べれば、十分に大きな計算量の改善をもたらしているとは言えないという。

トンプソンらは、高性能な小型ディープラーニングアーキテクチャの探索にも注目している。最近では、最適化を利用して,学習問題のいくつかのクラスで良好な性能を維持しつつ,学習に必要な計算効率の高いネットワークアーキテクチャを見つけることが一般的になってきている。多くの場合、非常に成功しているが、現在の欠点は、メタ学習やニューラルアーキテクチャ探索を行う際のオーバーヘッド自体が計算量が多いことだ。

ディープラーニングの計算限界を回避するためのもう一つの可能性のあるアプローチは、他の、おそらくまだ発見されていないか、あるいはまだ評価されていないタイプの機械学習に移行することだろう。トンプソンらは、ディープラーニングのアプローチが改善されても、単に計算能力の消費が減るだけではないことを期待している。これらの新しい技術を見つけるのは簡単なことではありませんが、もし広く応用可能なものが見つかれば、おそらくまた新たな応用の波が生まれる、とトンプソンらは予想している。

参考文献

Neil C. Thompson et al. The Computational Limits of Deep Learning. arXiv. July 10, 2020.

Photo by Nvidia.