MITとアドビ、コードなしで画像生成アルゴリズムを再プログラム

先週、MITとアドビがarXivに送った研究は、高度なアルゴリズムとシンプルなユーザーインターフェースの組み合わせがいかに可能かを示している。このチームは、ユーザーが組み合わせて見たい被写体の画像をいくつか選択すると、それに基づいて画像生成アルゴリズムを書き換える方法を考え出した。

先週、MITとアドビがarXivに送った研究は、高度なアルゴリズムとシンプルなユーザーインターフェースの組み合わせがいかに可能かを示している。このチームは、ユーザーが組み合わせて見たい被写体の画像をいくつか選択すると、それに基づいて画像生成アルゴリズムを書き換える方法を考え出した。

たとえば、帽子をかぶったジョッキーに乗られている馬の写真がある場合、馬の頭をクリックしてからジョッキーの帽子をクリックすると、アルゴリズムが帽子をかぶった馬の画像を生成する。ここで実際に動いているのを見ることができる例は、単純なものだが、コア技術は強力だ。

Wow. "Rewriting a Deep Generative Model" lets you directly rewrite StyleGAN2 model weights (visually, with a mouse) to make a new model, instead of training on a new data set.

— Jonathan Fly 👾 (@jonathanfly) August 27, 2020

pdf: https://t.co/EB0R9XS576

project: https://t.co/D1TahSoesy pic.twitter.com/94fBCh9aoL

GANのような深層生成モデルは、対象分布に関する豊富な意味的・物理的ルールの集合をモデル化するために学習するが、そのようなルールがどのようにネットワークにエンコードされているのか、あるいはルールがどのように変更されているのかは、これまで不明瞭だった。

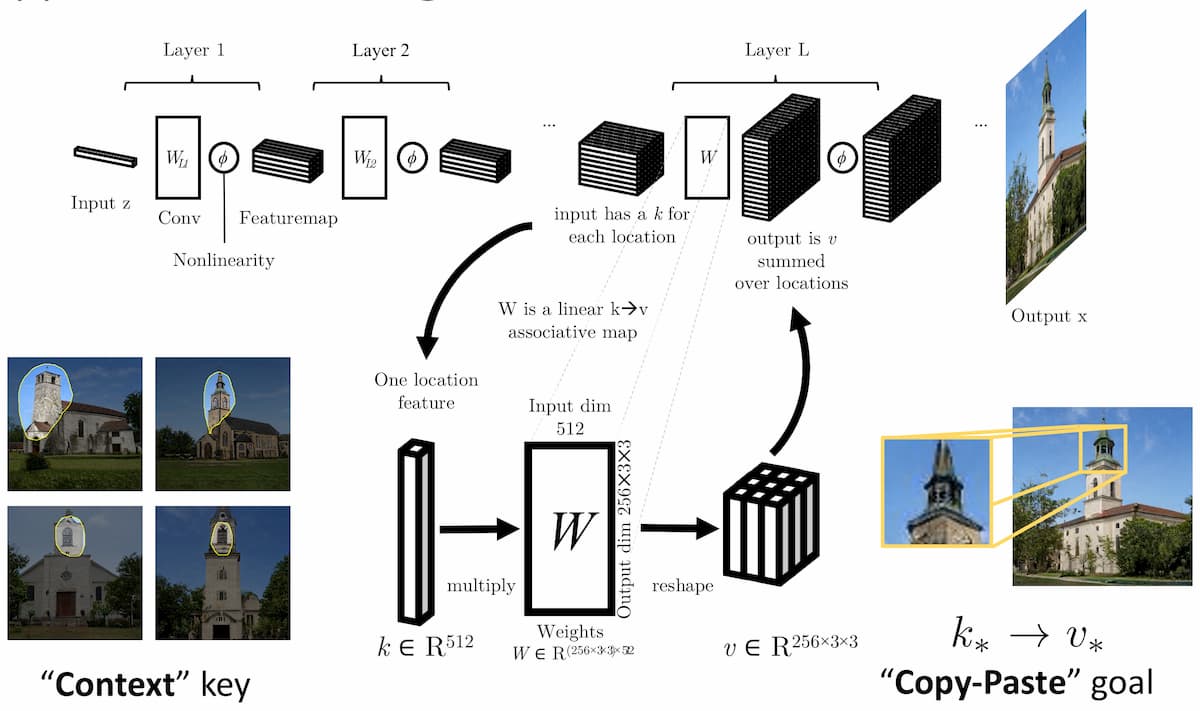

この論文「Rewriting a Deep Generative Model」(David Bau, Steven Liu, Tongzhou Wang, Jun-Yan Zhu, Antonio Torralba)では、新たな問題設定として、ディープ生成モデルによってエンコードされた特定のルールの操作を紹介している。この問題を解決するために、我々は、深層ネットワークの層を線形連想メモリとして操作することで、目的のルールを変更するという定式化を提案する。

チームは、連想メモリの一つのエントリを変更するためのアルゴリズムを導出し、いくつかの興味深い構造規則が、最先端の生成モデルの層の中に位置し、変更できることを実証した。また、ユーザが生成モデルのルールをインタラクティブに変更して目的の効果を得ることができるユーザインタフェースを提示し、いくつかの概念実証アプリケーションを示す。最後に、複数のデータセットを用いた結果から、標準的な微調整手法や編集転送アルゴリズムに対する本手法の優位性を実証する。

チームが採用した手法は、ジェネレーターの重みがOptimal Linear Associative Memory(OLAM)として機能するという仮説に基づいている。

OLAMは、1970年代にTeuvo KohonenとJames A Anderson(独立して)によって記述された、連想を記憶するための古典的な単層ニューラル・データ構造である。我々の場合、現代の大規模な多層畳み込みネットワークの中では、各層がOLAMの役割を果たしており、意味のある文脈を表すキーと出力を決定する値を関連付けるルールのセットを記憶しているという仮説を立てている。

彼らが提案する手法を使用して、シーン内のオブジェクトの新しい配置の追加、未定義の出力パターンの系統的な削除、物理的な光のモデリングのグローバルな変更など、いくつかの視覚的な編集効果を作成するために使用している。その手法はシンプルで高速であり、大量のアノテーションセットを必要としない。