サンプル効率が非常に高いロボット制御モデルFERM

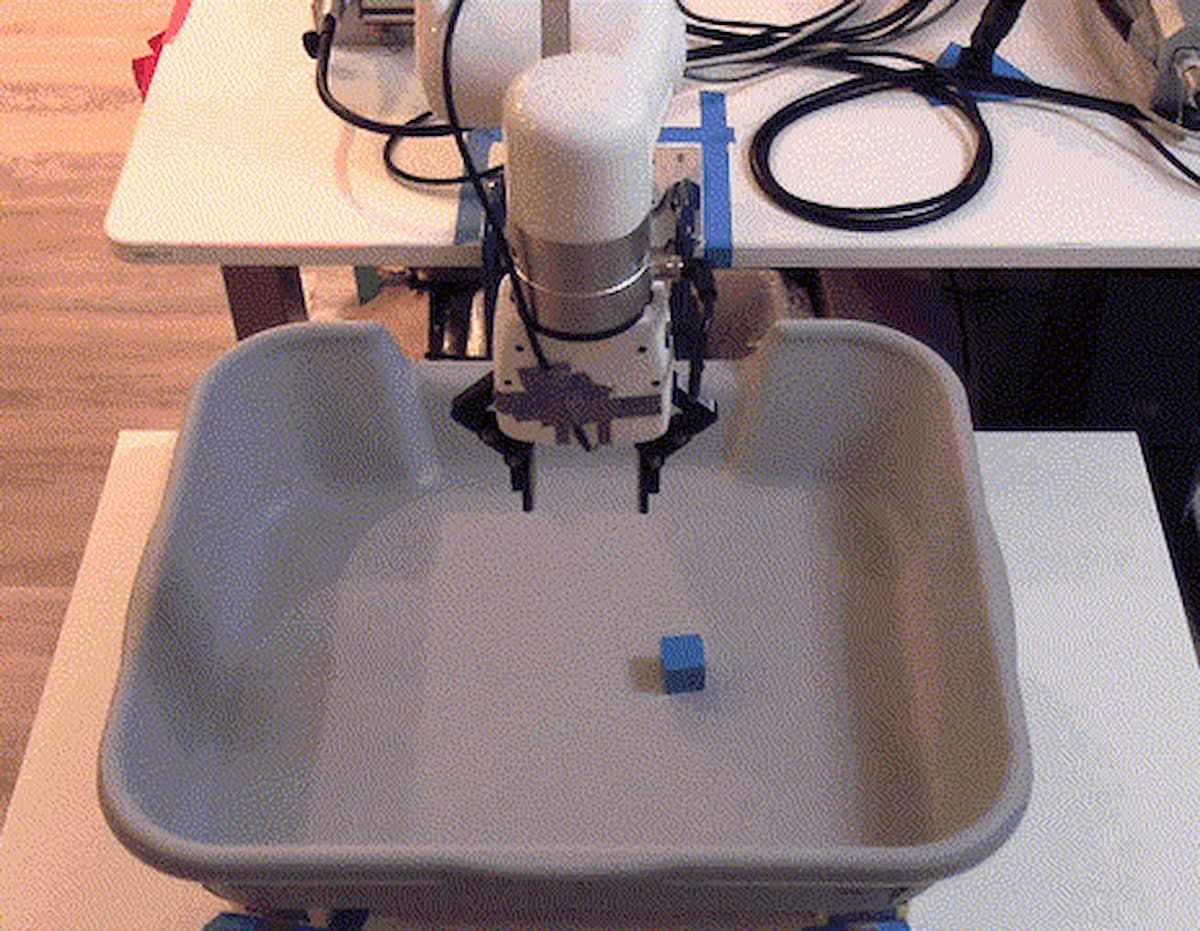

カリフォルニア大学バークレー校のピーター・アビール教授たちは、最先端の技術を活用して、「非常に」サンプル効率の高いロボット操作モデルのトレーニングを実現するフレームワーク「Framework for Efficient Robotic Manipulation (FERM)」を開発した。

カリフォルニア大学バークレー校のピーター・アビール教授たちは、最先端の技術を活用して、「非常に」サンプル効率の高いロボット制御モデルのトレーニングを実現するフレームワーク「Framework for Efficient Robotic Manipulation (FERM)」を開発した。共著者らによると、わずか10回のデモンストレーションで、15分から50分の実世界でのトレーニング時間が与えることができ、その結果、ロボットアームが、FERMを使って、大きな物体に手を伸ばしたり、つまんだり、動かしたり、引っ張ったり、スイッチをひっくり返したり、引き出しを開けたりすることを学習することができるという。

FERMは「ピクセルベース」の強化学習をよりデータ効率の良いものにすることで、自動化へのシフトを加速させるのに役立つかもしれない。FERMはまず少数の実演を収集し、それを「リプレイバッファ」に保存します。エンコーダの機械学習アルゴリズムは、再生バッファに含まれる実演データに対して事前に学習される。次に、FERMの強化学習アルゴリズムは、エンコーダと最初のデモの両方によって生成されたデータで「補強」された画像上で学習する。

研究者によると、FERMはロボット、グラフィックカード、2台のカメラ、一握りのデモンストレーション、そして強化学習アルゴリズムをゴールに向けて誘導する報酬機能を必要とするだけで、簡単に組み立てることができるという。実験では、FERMはxArm(UFactory社製の産業用ロボットアーム)が25分以内に6つのタスクを学習することを可能にし、平均成功率は96.7%だったという。このアームは、トレーニング中やデモンストレーション中には見られない対象物にまで一般化し、ゴール位置への道を塞ぐ障害物にも対処することができたという。

深層強化学習は、把持や手先の器用な物体操作など、多様なロボット操作方針の学習に有効な手法として知られている。しかし、これまでのところ、汎用的なRLアルゴリズムはサンプル効率が非常に悪く、ロボット工学の分野での普及には限界があった。

離散および連続制御のための最新の強化学習アルゴリズムは、ピクセル入力から効果的なポリシーを学習するために、多くの場合、約数千万回の環境インタラクションを必要としてきた。根底にあるプロプリオ知覚状態が知覚可能な場合でも、疎な報酬のロボット操作では、手を伸ばしたり、つまんだり、押したり、物を置いたりといった基本的なタスクで信頼できる成功率を達成するために、何百万ものトレーニングサンプルを必要とし、リアルタイムでのトレーニングには2週間程度を要することがわかっていた。

このような深層強化学習におけるデータ効率の課題を克服するために、多くの戦略が提案されてきた。

1つのアプローチはSim2Realであり、ここでは、強化学習ポリシーが最初にシミュレーションで訓練され、その後、実世界に転送される。このフレームワークでは、強化学習ポリシーはシミュレーションで訓練され、環境とエージェントの視覚的属性と物理的属性の両方がランダム化されて、トレーニングデータのサポートが拡張される。結果として得られたポリシーは、実世界のシステムに転送される。Sim2Realは効果的ですが、その欠点は、結果として得られるポリシーのばらつきが大きいことと、ドメインランダム化を用いてポリシーを訓練するのに必要な計算リソースが大きいことだった。

学習制御のもう一つの一般的なアプローチは、模倣学習]によるもので、多数の専門家のデモンストレーションを収集し、専門家の軌跡に回帰することで教師付き学習によってポリシーを抽出する。模倣学習では、通常、数百から数千の専門家の実演を必要とするが、これは収集に手間がかかり、結果として得られる政策は専門家の実演の質に左右される。特定の課題を解決するために必要な最適なポリシーを自律的に学習することが望ましい。

FERMは、教師なし事前学習とデータ拡張を伴うオフポリシー強化学習を利用し、簡単な3段階の手順で効率的な学習を行う。まず、少数のデモンストレーションを収集し、リプレイバッファに保存する。次に、デモデータを用いた教師なしの対照的な事前学習を用いて、畳み込みエンコーダの重みを初期化する。第三に、オフポリシーRLアルゴリズムは、トレーニング中にオンラインで収集されたデータと最初のデモデータの両方に対して、拡張画像を用いてトレーニングされる。

セットアップに必要なものは、ロボット1台、GPU1台、カメラ2台、少数のデモンストレーション、そして疎な報酬関数である。これらの必要条件は、Sim2Real、モーションキャプチャー、複数のロボット、工学的な密な報酬に依存するセットアップに比べて非常に軽量である。

「我々の知る限りでは、FERMは、疎な報酬の多様なロボット操作タスクのセットをピクセルから直接1時間以内に解決する最初の方法だ」と研究者は書いている。「我々の研究は、迅速かつ効率的な方法で実際のロボットに強化学習を適用するための刺激的な道筋を提示している」。

FERMのようなオープンソースのフレームワークはロボット操作の技術を進歩させることを約束しているが、進歩をどのように測定するかについては疑問が残っている。ロボットによる把持の進歩を測定するために使用される測定基準はタスクに応じて異なる場合がある。例えば、宇宙のようなミッションクリティカルな環境で動作するロボットでは、何よりも精度が重要になる。

近年の深層強化学習の進歩により、自律的な意思決定において前例のない能力が生まれている。これまでの研究では、ビデオゲーム、囲碁、チェス、将棋、花火などの複雑な古典ゲーム、シミュレーションと実世界の両方での自律的なロボット操作方針の学習などが挙げられる。

参考文献

Albert Zhan, Philip Zhao, Lerrel Pinto, Pieter Abbeel, Michael Laskin. A Framework for Efficient Robotic Manipulation. arXiv:2012.07975 [cs.RO].

Image via "A Framework for Efficient Robotic Manipulation" https://sites.google.com/view/efficient-robotic-manipulation