Google AI研究者ら、機械学習のデータセットには文化の変化が必要と主張

機械学習コミュニティ、特にコンピュータビジョンと言語処理の分野では、データセットの収集と利用において深刻な文化の問題を抱えている、と今月初めに発表された、Google ResearchのリサーチサイエンティストEmily Dentonらが共著した論文は主張している。

機械学習コミュニティ、特にコンピュータビジョンと言語処理の分野では、データセットの収集と利用において深刻な文化の問題を抱えている、と今月初めに発表された、Google ResearchのリサーチサイエンティストEmily DentonとAlex Hanna、ワシントン大学教授(計算言語学)のEmily Benderらが共著した論文は主張している。

この論文は、機械学習におけるデータの収集・利用方法について提起された多くの懸念事項の文献調査を行い、この分野の実践的・倫理的な問題のいくつかに対処するためには、データに対するより慎重で徹底した理解が必要であると提唱している。

データセットは、アルゴリズム開発と科学的進歩を制限する要因として見られてきた。また、ベンチマークデータセットは、機械学習コミュニティの目標、価値観、研究課題を方向付ける上で重要な役割を果たしてきた。近年、機械学習システムは、英語テキスト理解のためのGLUEベンチマークのようなベンチマークデータセットで評価された場合、「超人的」な性能を達成することが報告されている。

しかし、Benderらは「しかし、人間のような推論能力の意味のあるテストとして、そのようなデータセットの欠点が表面化した最近の研究は、このような進歩のように見えることが、いかに欠陥のある基礎に安住している可能性があるかを明らかにしている」と主張した。

専門家ではないクラウドワーカーへの依存度が高まるとともに、ウェブからますます大量のデータを自由に収集する方向へと向かうことは、機械学習にとっての恩恵とみなされたが、これらのデータ手法は、データセットの生成に関わる人間の労働、主観的な判断やバイアス、偶発的な文脈を抽象化する傾向がある。「巨大なスケールは、一般性と客観性にとって有益であると神話化されてきたが、すべてのデータセットには限界とバイアスがある」とBenderらは記述している。

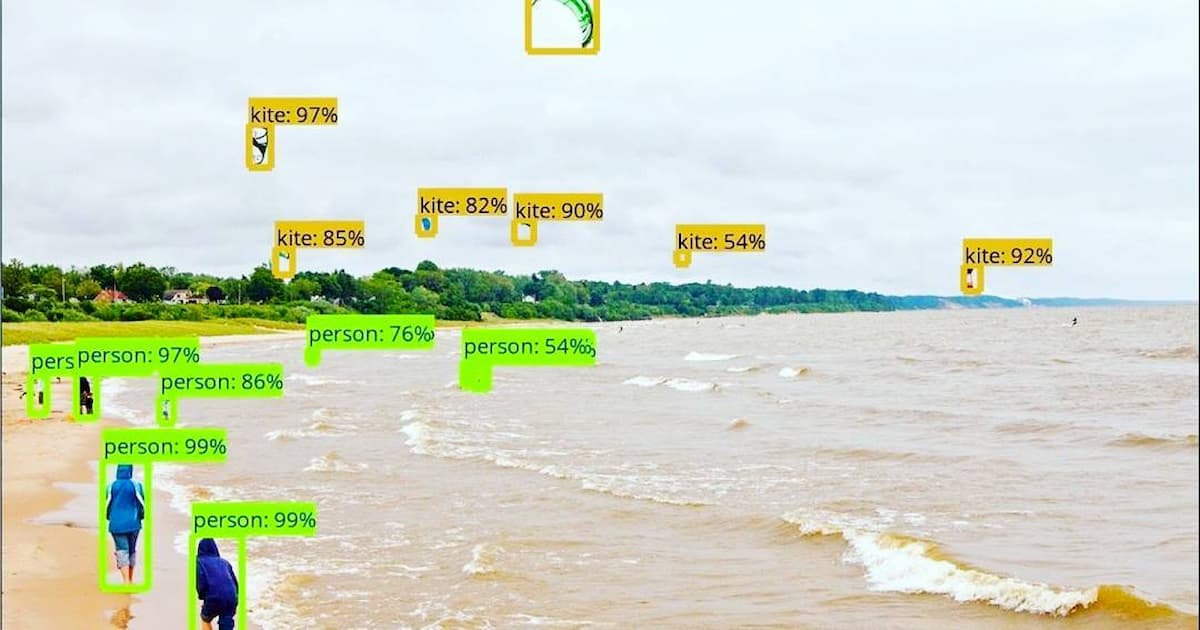

著者らは文献調査を通じて、顔認識データセット内で、肌の色の濃い被験者の過少表現が確認されていることや物体認識データセット内の画像は圧倒的に欧米諸国からのものであることを指摘した研究など多数の論文を引用している。

共著者のEmily BenderはGoogleがTimnit Gebruを解雇した際にその発端となったと考えられる論文の草稿の共同執筆者であり、彼女はその草稿をいくつかのメディアに提供し、Google AIで起きたことを外に知らしめるのに貢献した。その論文は、大規模な言語モデルの社会への負の影響を検討したもので、2020年12月末、フェアネス、アカウンタビリティ、トランスペアレンシー(FAccT)カンファレンスの主催者が出版を承認している。

また同じく12月末には、共著者のHannaはGoogleの倫理的AIチームの同僚と一緒に、Gebruの復職を要求するメモをGoogleの経営陣に送った。同日、アルゴリズム・バイアスに関心のある議員たちは、Googleのスンダル・ピチャイ最高経営責任者(CEO)にGebruの解雇を巡る状況について説明を求める書簡を送っている。

参考文献

- Amandalynne Paullada, Inioluwa Deborah Raji, Emily M. Bender, Emily Denton, Alex Hanna. Data and its (dis)contents: A survey of dataset development and use in machine learning research. arXiv:2012.05345 [cs.LG]

Photo: "The future of computer vision with the TensorFlow Object Detection API from Google. You won't have to describe any photo...."by ShashiBellamkonda is licensed under CC BY 2.0