アルゴリズムバイアスと公平性の議論は急を要する

機械学習の発展とともに社会に実装されるアルゴリズムが増えているが、アルゴリズムに致命的なバイアスがあり、社会に決定的な影響を与えている例が指摘されている。「アルゴリズムの公平性」「説明可能なAI」と定義された新しい社会の課題が生まれ、様々なステークホルダーによってその解決が図られている。

要点

機械学習の発展とともに社会に実装されるアルゴリズムにバイアスが増えているが、アルゴリズムにバイアスがあり、それは社会に決定的な影響を与えている例が指摘されている。アルゴリズムの公平性、説明可能なAI等の言葉で定義された新しい社会問題が生まれ、その解決が待たれている。

機械学習 / AIの進歩が生み出した問題

我々の社会では2012年以降、機械学習に関して大きな技術的変化が引き起こされた。会話型AIやコンピュータビジョン、予測など、人々は様々な種類のAIを使う能力を獲得した。

人間が機械で能力を拡張する手法に革命的な変化が起きつつある。過去に人間が肉体的な方法で私たち自身を増強してきたが、現在の増強の性質はより知的だ。AIによって誘導される自動運転車の先端にいる。 他のデバイスは、よりインテリジェントになるさまざまな段階にある。その過程で、人と機械の相互作用(Human machine interaction)が変化している。

だが、近年、大きな課題が生まれた。それはアルゴリズムにバイアスが存在する可能性があることだ。適切に設計された機械知性は、一貫性があり、最適な意思決定に役立つ。そのマシンインテリジェンスは 性質上、数学的に論理的である可能性があり、プログラムの指示から外れることはない。たとえば、適切に設計された機械学習アルゴリズムでは、人々が頻繁に示す非論理的な好みの変化に遭遇することはない。 統計誤差の範囲内で、機械知性の決定は一貫していると想定できる。

問題は、機械知性が常に適切に設計されているわけではないことだ。Amazonの採用に用いられた機械学習アルゴリズムやGoogleの画像ラベリングのように後に不公平であることが判明した機械学習アルゴリズムの例はたくさんある。Amazonは採用のための履歴書のスクリーニングを自動化するためのシステムを機械学習で開発したが、Amazonはこのシステムが女性に対して不利益に働くことに気づき、このシステムの利用を停止したとガーディアン紙は伝えた。ソフトウェアエンジニアのジャッキーアルシネは、Googleフォトの画像認識アルゴリズムが黒人の友人を「ゴリラ」として分類していることを指摘した。Googleはアルシネに謝罪し、問題を解決することを約束しないといけなかった。

アルゴリズムバイアスとは?

アルゴリズム・バイアスとは、コンピュータ・システムの出力から生じる公平性の欠如のことである。アルゴリズム・バイアスで説明される公平性の欠如は、様々な形で現れるが、特定のカテゴリーの区別に基づいて、あるグループを差別することとして要約することができる。

アルゴリズム・バイアスにはいくつかの形態があり、例えば、人種バイアス、年齢差別、ジェンダー・バイアスなどがある。あなたがどのような年齢、人種、性別であるかはわからないが、誰もがアルゴリズム・バイアスの危険にさらされていることは間違いない。

今日のアルゴリズムや機械学習システム内のバイアスは、もともと社会に存在した状況の反映として現れている。ディープラーニングモデルは、ニューラルネットワークが持つパターン認識能力を引き出す形で機能している。したがって、ディープラーニングモデルは設計上、直接バイアスをかけることはできず、バイアスの出現や原因はニューラルネットワークのアーキテクチャや設計の外部にある。

機械学習モデルやAIシステムによって生成される出力は、トレーニングデータを反映したものに過ぎない。トレーニングデータとデータがアルゴリズムのバイアスを引き起こす可能性があると私が考える方法は主に2つある。ひとつが、データ収集者によるバイアス、もうひとつが環境的なバイアス(社会のバイアス)である。

最も恐ろしいのは、このバイアスを含んだアルゴリズムが、社会に基からあるバイアスを強化するというフィードバックループに陥ることだ。黒人に対する差別が、アルゴリズムを通じて社会の中で強化されていくのは非常に危険であり、数理モデルが「数学破壊兵器」に変わる瞬間とも言えるだろう。

アルゴリズムの公平性

機械学習研究者と実践者は、彼らのアルゴリズムが訓練データのバイアスを永続させる可能性があることを懸念しており、システムがすでに不利な立場にある人々のグループを差別してほしくないと考えている。

研究者は、最初から公平性を確保する制限を課すために取り組んできた。たとえば、CB(カラーブラインド)と呼ばれるアルゴリズムは、人種や性別などの識別変数を結果の予測に使用してはならないという制限を課す。もう1つはDP(人口統計パリティ)と呼ばれ、グループが相応に公平であることを保証する。

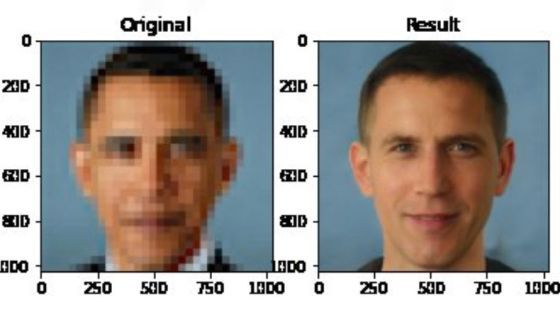

モザイク除去の研究が人種差別の議論に発展するであったり、機械学習のトップ会議が論文に「社会へのインパクト」を明記することを義務化したり、アカデミアでも社会の要請に答えて技術を発展させようという姿勢が明確になってきた。モザイク除去の件では、チューリング賞を2018年に受賞した、Facebookの人工知能部門におけるチーフ研究者、ヤン・ルカンは、人工知能および機械学習における人種差別の議論で多くの非難を受け、Twitterアカウントを停止することにまで発展した。

現実的な方法としては、アルゴリズムに潜在的なバイアスや差別がないかどうかを時々テストすることが考えられる。米下院のアルゴリズム説明責任法(Algorithm Accountability Act)で義務付けられているように、企業自身がこのテストを実施することもできる、提案されている人工知能正規化フォーラム(Forum for Artificial Intelligence Regularization: FAIR)のような独立した非営利の認定委員会がテストを実施することもできるだろう。

テストが公正であることを確認するためには、データ自体が公正である必要がある。例えば、犯罪予測アルゴリズムは、人種や少数民族の人々が過剰に存在する過去の犯罪データを分析しているため、アルゴリズムが正しく構築されていても、偏った予測をしてしまう可能性がある(詳しくはこちら)。そのため、代表的なデータセットをテストに利用できるようにする必要がある。

日本でも機械学習と公平性のテーマは深く捉えられている。人工知能学会倫理委員会等は「機械学習と公平性に関する声明」を出した。生命は「機械学習は道具にすぎず人間の意思決定を補助するものであること」「私たちは、公平性に寄与できる機械学習を研究し、社会に貢献できるよう取り組んでいること」の二点を表明している。

このような変化を実現することは容易ではない。機械学習と人工知能が私たちの生活に欠かせないものになっていく中で、私たちは法律や規制が遅れないようにしなければならない。機械学習はすでに産業全体に革命を起こしており、私たちはその革命の始まりの世代に過ぎない。私たち市民は、機械学習の利益が公平に分配されるように、アルゴリズム開発者とユーザーに説明責任を負わせる必要がある。適切な予防措置をとることで、アルゴリズムの偏りがバグであり、将来のアルゴリズムの特徴ではないことを確実にすることができる。

健康リスク予測アルゴリズムの誤り

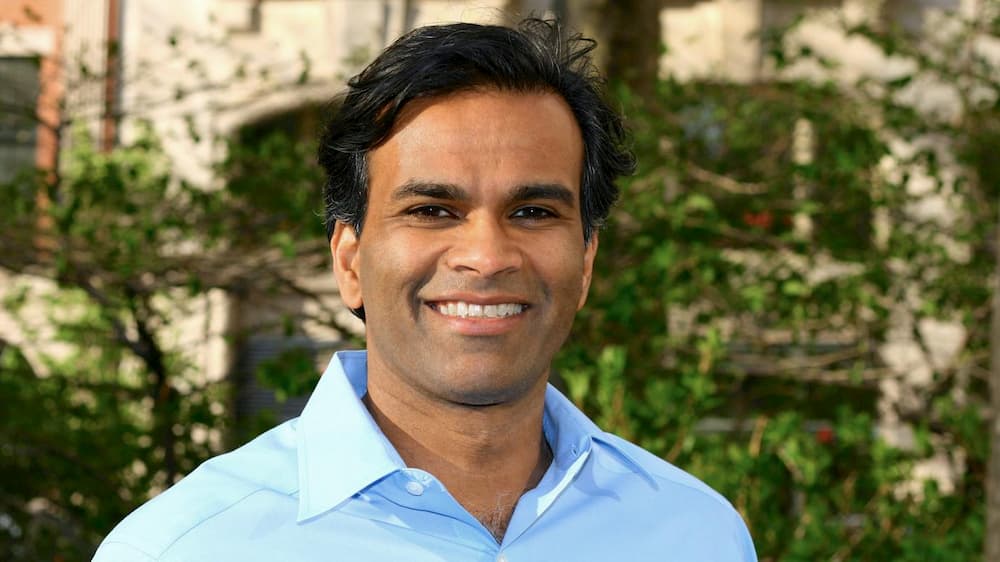

不公平なアルゴリズムを評価し、公平なアルゴリズムに交換することに成功した例がある。それはカルフォルニア大学バークレー校のZiad Obermeyer准教授らがサイエンス誌で発表した医療機関が利用する健康リスク予測アルゴリズムに関する研究である。

米国の医療システムでは、健康上の意思決定の指針となる商用アルゴリズムが使用されている。カルフォルニア大学バークレー校のZiad Obermeyer准教授らは、広く使用されている健康リスク予測アルゴリズムの1つに人種的偏りの証拠を見つけた。この新たな研究によれば、広く用いられているこのツールは、黒人患者のニーズを白人患者よりも過小評価しているという。同じリスクスコアでみると、このアルゴリズムによると黒人患者は同様の病気を有する白人患者よりも健康であると判定され、その結果、さらなるケアが必要と見なされる黒人患者の数が少なくなる。この結果から、こうしたバイアスが生じる理由はこのアルゴリズムによる健康上のニーズの予測が、実は医療費の予測であるためであることが示される。

医療施設では、健康リスクを予測して最もニーズの高い人にリソースを割り当てるために、アルゴリズムを用いた予測の使用に頼ることが多くなっている。これらの自動化システムにバイアスがあるという可能性は、認識される懸念として増大しつつあるが、大部分がパテントで守られている市販の健康評価アルゴリズムに対する独立した評価はあまり行われていなかった。

Obermeyerらは、この人種的バイアスにより、追加治療を必要とする黒人患者の数が半分以上減少すると推定し、ニーズの代理としてコストを使わないようにアルゴリズムを再構築することで、余分なケアを必要とする人を予測する際の人種的な偏りを排除することができる、と主張。Obermeyerらは、別の代理指標を用いてこのアルゴリズムを改訂することで、人種的バイアスが84%低下したことを示した。今回の結果に基づいて、著者らはこのアルゴリズムの開発者と協働して、バイアスを低減するための作業に取り組みを開始したという。

再販予測アルゴリズムCOMPASが示した「公平性」の定義の限界

ただし、公平性の定義には限界があることがわかってきた。それは再犯予測アルゴリズムCOMPASをめぐる議論で明るみに出た。COMPASとは、犯罪者たちの再犯可能性を予測するために導入されたシステムだ。米国の一部の州では、アルゴリズムが再犯予測に使用され、裁判を待っている被告人を保釈するには危険すぎるかを決定するようになった。場合によっては、黒人の被告人が白人の被告人よりも、高リスクとして誤って分類される可能性がかなり高いとされている。これが2016年に問題になった。

COMPASは、保釈金の額の割り当てや判決の決定など、プロセスのあらゆる段階で裁判官の決定を支援するために、現在では一般的に使用されている。理想としては、これらのアルゴリズムは、個々の裁判官がより公平に正義を執行するのに役立ち、法廷制度全体の刑罰の不整合を根絶するのに役立つことが期待されていた。

開発元のNorthpointeは犯罪者の再犯可能性の評価のために、一般的および暴力的な再犯、および公判前の不正行為に対するリスク尺度を作成し、使用すると説明する。アルゴリズムはリスクの算定に被告人の137項目のアンケートへの回答も活用する。

しかし、COMPASの黒人に対する偽陽性の確立の高さが俎上にあげられることとなった。ProPublicaのジャーナリスト、ジュリア・アングウィンは2015年にCompasのアルゴリズムにはアフリカ系アメリカ人へのバイアスが存在すると主張した。黒人の被告人は白人の被告人よりも、将来的に再犯しないのに誤って高リスクと分類される割合が高かった。アングウィンは白人と黒人の間の「偽陽性」の差異をバイアスの証拠とした。

これに対し、Northpointeは、さまざまな学者とともに、ProPublicaの分析に疑問を呈した。彼らは、再犯のリスクが中程度または高いと予測した被告人は、人種に関係なくほぼ同等の割合で再犯しているため、実際には公平であると主張している。COMPASの真の陽性率は人種的に中立であるように見える。

他の専門家は、この議論は「公正の定義」にかかっており、NorthpointeとProPublicaの両方が設定した基準を満たすことは数学的に不可能である、と指摘した。

代表的なのはスタンフォード大学大学院博士課程のSam Corbett-DaviesとEmma Piersonである。彼らはCOMPASが人種にかかわらず、正確に予測をしていると主張した。彼らは、アルゴリズムがふたつの集団に対して同程度に信頼でき、なおかつ一方の集団の方がもう一方よりも再犯率が高いとすれば、黒人が誤って高リスクと分類される確率は必然的に高くなってしまう、と指摘した。そうでなければそのアルゴリズムはふたつの人種に対して、公平に較正されていないことになる。白人と黒人で異なる評価を行なわなければならなくなるからだ。つまり、彼らは公共の安全を向上させることとアルゴリズムの公平性という一般的な概念を満たすことの間にはトレードオフがある、と主張した。

これは、アングウィンが主張した、偽陽性の偏りをアルゴリズムの不公平性の証拠とする主張の大元を否定したことにもなる。アルゴリズムを公平にした結果、人種間の偏りが生まれてしまうが、それを是正するには、アルゴリズムを「不公平」にしないといけないからだ。また、黒人被告人の全体的な再犯率は白人被告人よりも高いため、アルゴリズムが100%正確でない限り(これは実際には達成不可能)、NorthpointeとProPublicaの両方の公平性の定義を同時に満たすことは数学的に不可能である。そう、これはトレードオフだった。

なぜ、黒人の再犯率が高いかというと、逮捕時の年齢が若い。一般的に年齢が若いほうが再犯率が高い。だとすれば、黒人と白人に対して異なるモデルを適用すれば、黒人の偽陽性を白人のそれと同水準まで押し下げられる可能性があるが、最高裁判決によると、モデルは全集団に対し同程度正確でなければならない。合衆国憲法が規定する「法の下の平等」である。COMPASは様々な制約の中で今のアルゴリズムの形を表現しているようだ。

バイアスのかかったアルゴリズムのほうが、バイアスのかかった人々よりも直すのが容易?

しかし、そもそも社会は公正なのだろうか? そもそも公平性を一定のフレームのもとに落ち着けることができるだろうか? そもそも「Fairness」を公平性と訳していていいのだろうか。政治思想を紐解いてみれば、あなたは長い議論の歴史(そしてそこに答えがないこと)を知ることができるはずだ。公平性は概念であり、なにかしら定量化できるものではないのだ。

ただし、面白いやり方がある。それは人間のバイアスを取り除くのではなく、アルゴリズムのバイアスを取り除くやり方だ。シカゴ大学のSendhil Mullainathan教授(計算科学, 行動科学)はニューヨークタイムズに寄稿し、「バイアスのかかったアルゴリズムのほうが、バイアスのかかった人々よりも直すのが容易だ」と主張している。

Mullainathanが15年前に公開した研究では、ほぼ同じ内容の履歴書だが、 一人はジャマル、もう一人はブレンダンというふうに、アフリカ系アメリカ人または白人の響きの名前がランダムに割り当てられた。チームは白人の名前は、インタビューのコールバックを50パーセント多く受け取る結果を得た。 人種的な格差は、職業、産業、雇用主の規模にかかわらず均一だった。

今年発表されたMullainathanも関わった研究では、研究チームは2人の患者が医療を求めている状況を扱った。どちらも糖尿病と高血圧に取り組んでいた。 1人の患者は黒人で、もう1人の患者は白人だった。米国のヘルスケアシステムでは、企業が開発したアルゴリズムを使用して、健康に関する意思決定を行っている。筆頭筆者のObermeyer等は、広く使用されている1つのアルゴリズムで人種的偏見の証拠を見つけた。それはアルゴリズムによって同じレベルのリスクを割り当てられたアフリカ系の患者は白人の患者よりも疾患が重度のものだったことだ。バイアスが発生するのは、アルゴリズムが治療ニーズの尺度として健康コストを使用するためとチームは断定した。同じレベルの治療ニーズを持っているアフリカ系の患者に費やされるお金が少ないため、アルゴリズムは、アフリカ系の患者は同じように病気の白人の患者よりも健康であると誤って結論付ける。

解決策はアルゴリズムを修正することだ。チームはアルゴリズムを再定式化して、治療ニーズの尺度としてコストを使用しないようにすると、誰が特別な注意を必要とするかを予測する際の人種的偏見がなくなると主張した。

Mullainathanはひとつめの研究で、特定のグループによる差別的な行動を統計的に特定することは、多くの場合非常に困難だったと書いている。対照的に、アルゴリズムによる差別の発見ははるかに簡単だったそうだ。つまり、白人の名前が黒人の名前よりも有利に働くことを示すには、他のステータスが同じで人種のみが異なる環境を作成する必要があるという。しかし、アルゴリズムの場合、適切なデータを供給してその動作を観察するだけで、等しく制御されたものを作成できる。

Mullainathanは、アルゴリズムと人間は、バイアスが見つかったときにできることが異なる、と指摘した。 人々の心を変えることは簡単なことではないが、 アルゴリズムの変更は、人の考えの変更よりも簡単だ。コンピューター上のソフトウェアはいつでも更新が可能だからだ。

2018年の論文で、Mullainathanは、Cass Sunstein、Jon Kleinberg、Jens Ludwigとともに楽観的な見方を提示し、それについて議論し結果、「適切な規制」があれば、アルゴリズムは差別を減らすのに役立つという結論に至ったと主張している。「適切な規制」のためにはアルゴリズムのテストと作成に使用されるデータを含む、アルゴリズムへのすべての必要な入力が慎重に保存されるようにする必要があるとMullainathanは主張している。

Become a Patron!参考文献

- IEEE, Ethically Aligned Design — A Vision for Prioritizing Human Well-being with Autonomous and Intelligent Systems, First Edition, 2019.

- Sendhil Mullainathan. Biased Algorithms Are Easier to Fix Than Biased People.. 2019. NewYork Times.

- Ziad Obermeyer et al. Dissecting racial bias in an algorithm used to manage the health of populations. Science 25 Oct 2019:Vol. 366, Issue 6464, pp. 447-453.

- 内閣府, 人間中心のAI社会原則.

- Daniel Ensign et.al. Runaway Feedback Loops in Predictive Policing

- G. O. Mohler, M. B. Short, P. J. Brantingham, F. P. Schoenberg, G. E. Tita. Self-exciting point process modeling of crime. 2011.

- PredPol (2018). Science and Testing of Predictive Policing. White Paper.

Photo by Ryoji Iwata on Unsplash

Special thanks to supporters !

Shogo Otani, 林祐輔, 鈴木卓也, Mayumi Nakamura, Kinoco, Masatoshi Yokota, Yohei Onishi, Tomochika Hara, 秋元 善次, Satoshi Takeda, Ken Manabe, Yasuhiro Hatabe, 4383, lostworld, ogawaa1218, txpyr12, shimon8470, tokyo_h, kkawakami, nakamatchy, wslash, TS, ikebukurou 太郎.

月額制サポーター

Axionは吉田が2年無給で、1年が高校生アルバイトの賃金で進めている「慈善活動」です。有料購読型アプリへと成長するプランがあります。コーヒー代のご支援をお願いします。個人で投資を検討の方はTwitter(@taxiyoshida)までご連絡ください。

投げ銭

投げ銭はこちらから。金額を入力してお好きな額をサポートしてください。