自然言語をモバイルUIアクションにマッピングするGoogleのオープンソースAI

Googleは、自然言語の命令のシーケンスをモバイルデバイスのUIでアクションに変換するためのAIモデルをオープンソース化した。このモデルはTransformerディープラーニングアーキテクチャをベースにしており、プロジェクトのために作成された新しいベンチマークデータセットで70%の精度を達成している。

Googleは、自然言語の命令のシーケンスをモバイルデバイスのUIでアクションに変換するためのAIモデルをオープンソース化した。このモデルはTransformerディープラーニングアーキテクチャをベースにしており、プロジェクトのために作成された新しいベンチマークデータセットで70%の精度を達成している。

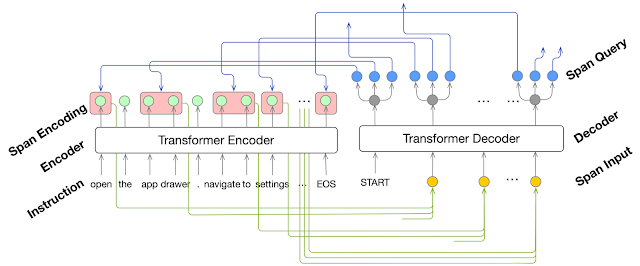

Google Researchの科学者チームは、先日開催されたAssociation for Computational Linguistics(ACL)カンファレンスで、このモデルを説明する論文を発表した。このプロジェクトの目的は、視覚障害者や一時的に「ハンズフリー」モードが必要なモバイルデバイスユーザーのための自然言語インターフェースの開発を支援することにある。1つ目は自然言語の指示を一連の「アクションフレーズ」に変換し、2つ目はアクションフレーズを画面上のUIオブジェクトとマッチングさせることで「地に足のついた」状態にするTransformerの2つのモデルを順番に使用している。研究科学者のYang Liがこのプロジェクトを説明するブログ記事で次のように述べている。

この作業は、UIの詳細を操作する必要性を軽減し、モバイルデバイス上でのタスク自動化のための技術的基盤を構築する。

トランスフォーマー(Transformer)は、2017年にGoogleによって開発された、入力シーケンスを出力シーケンスにマッピングするための深層学習アーキテクチャです。これは、リカレント・ニューラル・ネットワーク(RNN)のような他のシーケンス学習アーキテクチャと比較して、学習の安定性や推論の高速化など、いくつかの利点を持っている。トランスフォーマーの主要な操作は注意であり、入力と出力のシーケンスの異なる部分の間の関係を学習する。例えば、ある言語から別の言語に翻訳するように訓練されたトランスフォーマーでは、アテンションはしばしば、ソース言語の単語とターゲット言語の単語のマッピングを学習する。

Googleの新しいAIでは、あるトランスフォーマーは、エリア・アテンションと呼ばれる注意の一形態を使用して、"navigate to"などのように、離散的なアクションにマッピングされた入力命令の中の隣接する単語のスパンを識別している。このトランスフォーマーは、自然言語の入力命令のシーケンスをUIアクションを表すタプル(順序付けされた不変のオブジェクトの集合)のシーケンスに変換する。各タプルは、操作(「開く」や「クリック」など)、操作するオブジェクトの説明(「設定」や「App Drawer」など)、オプションのパラメータ(テキストボックスに入力するテキストなど)で構成されている。これらのアクションを実行するためには、正しいUIオブジェクトを識別することで、これらのアクションが接地されている必要がある。このトランスフォーマーへの入力には、アクションフレーズのタプルと、現在デバイスの画面上にあるUIオブジェクトのセットの両方が含まれる。トランスは、アクションフレーズのタプルからの説明に基づいてオブジェクトを選択することを学習する。

モデルを訓練するために、Googleは2つのデータセットを作成した。アクションフレーズ抽出トランスフォーマーを訓練するためのAndroidHowToと呼ばれるデータセットは、Androidデバイスに関連する「ハウツー」の質問への回答を求めてウェブをスクレイピングして収集された。人間のアノテータは、回答の指示に含まれるアクションフレーズのタプルを識別することで、データにラベルを付けた。最終的なデータセットには、約10,000件のラベル付けされた命令が含まれており、190,000件のアクションを表している。接地変圧器については、RicoSCAと呼ばれる合成データセットを作成した。AndroidアプリのUI画面を72k個収録したRicoという一般に公開されているデータセットから、チームは画面からUI要素をランダムに選択し、"tap" や "click" などのコマンドを生成した。結果として得られたデータセットには、約30万個のコマンドが含まれている。

システムの総合的な性能を評価するために、研究チームはPixel電話のヘルプページからコンパイルされたPixelHelpと呼ばれるデータセットを作成した。人間のオペレータは、ページに記載されているタスクを実行するために、ピクセル電話のエミュレータを使用した。ロガーが彼らの行動を記録し、自然言語命令とUI操作のマッピングを作成した。結果として得られたデータセットには、187個の多段階命令が含まれている。このデータセットで新AIを評価したところ、70.59%の精度を達成した。

Googleの新AIは、モバイルデバイスの自然言語自動化に向けた数多くの取り組みのうちの1つ。Appleは2018年にSiri Shortcutsを導入し、ユーザーが音声コマンドでトリガーできる一連のアクションを定義できるようにした。AmazonのAlexは最近、ディープリンクをサポートするアプリを自動化する機能を導入した。SiriとAlexaのソリューションはどちらも、アプリが明示的にサポートする必要がある。対照的に、GoogleのAIはデバイスのUI上で直接操作を学習するため、どんなアプリでも利用できる。

参考文献

- Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, Illia Polosukhin. Attention Is All You Need. arXiv:1706.03762. ubmitted on 12 Jun 2017 (v1), last revised 6 Dec 2017.

- Yang Li et al. Mapping Natural Language Instructions to Mobile UI Action Sequences. arXiv:2005.03776. Submitted on 7 May 2020 (v1*), last revised 5 Jun 2020 (this version, v2).

Photo by Google.