機械学習とGPUが辿った経緯

NVIDIAは機械学習用のチップを事実上独占。しかし、2018年頃に機械学習ブームが成熟を迎えると、データセンターにおけるGPU需要は一服した。

コンピュータの守護聖人であるアラン・チューリングは、トランジスタベースのコンピュータが存在する前の1950年に、AIに関する画期的な論文を書いた。多くの優れたコンピュータ科学者がAIに取り組んでおり、チューリング賞を受賞していることからもわかるように、多くの優れたコンピュータ科学者がAIに取り組んでいる。さらに最近では、カナダ人2人とフランス人1人の計3人の研究者が、上記のすべてのイノベーションを可能にしたディープラーニング革命を主導した。

このようなコンピュータ科学の進歩は緩やかなものではない。科学はその代わりに、革命と挫折のサイクルで機能する。ハイプサイクルとも呼ばれるでしょう。 1950年以降、AIに大きな進歩がなかった年が何年もあった。AIの科学者はこれらの時をAIの冬を呼ぶ。

AIの最新のディープラーニング革命は、①膨大なデータ量②そのデータを処理するための膨大な計算量③オープン性の高い研究とオープンソースコード、が利用可能になったことが要因だった。

90年代からコンピュータが普及し、膨大な量のデータが収集されるようになった。「データは新しい石油である」という言葉を誰もが耳にしたことがあるはずだ。2009年、スタンフォード大学の研究者たちは、画像の中に何が入っているかを説明した1400万枚の画像のデータベースであるImageNetを発表した。この大規模なデータセットにより、AIは模範によって見る方法(コンピュータビジョン)を学習することができた。同時に、翻訳、音声認識、その他の認知分野のための大規模なデータセットも作成された。Imagenetやその他のデータセットは世界中の研究者が利用できるようになり、研究者同士で手法を試すためのコンペが開催された。

CPUでは必要な計算量を提供することができなかったため、GPUはこのデータを処理するために非常に重要だった。計算能力が指数関数的に増加するというムーアの法則は、2010年代にはCPUでは機能しなくなった。もともとゲーム用に設計されたGPUは、ムーアの法則を継続するための代替手段を提供してくれました。GPUは、超安価なスーパーコンピュータでなければできない計算能力を備えていた。GPUは、以前は一部の人しかアクセスできなかったスーパーコンピュータを本質的に民主化した。

最後に、最新のAI革命のオープン化によって、世界中の研究者が協力して爆発的な量の研究を生み出すことができるようになった。AIの研究者たちは、ペイウォールに隠れて研究を守る伝統的な学術誌を拒絶してきた。2005年のこの論文は非常にお勧めだ。この論文が発表されてから、さらに多くのクールなことが起こった。 彼らの研究を再現したコード(つまり手法)をオープンソース化して、他の人がそれに基づいて構築できるようにしている。これは、コンピュータサイエンスを問わず、あらゆる研究者にとって夢のようなことだ。

GPUとNvidia

AIにおけるGPUの重要性が理解できたところで、次はNvidiaの台頭について見ていきましょう。Nvidiaは、AIの台頭以前からGPUのトップメーカーであり、現在もその地位を維持している。ハードウェア面だけでなく、ソフトウェア面でもAI革命の重要なパートナーとして活躍してきた。

GPUは多くの演算能力を蓄えていますが、特にプログラムを組むのが大変だった。ゲーム業界はこれを認識し、OpenGLと呼ばれるツールの共通ライブラリに収束した。しかし、これらのツールは、AIが数学を扱うのに対し、グラフィックスを扱うものばかりだったため、AI研究者にとってはどれも役に立たなかった。そこでNvidiaは、Nvidia GPU上での数学のコーディングを容易にするCUDAと呼ばれるソフトウェア・ライブラリを提供した。

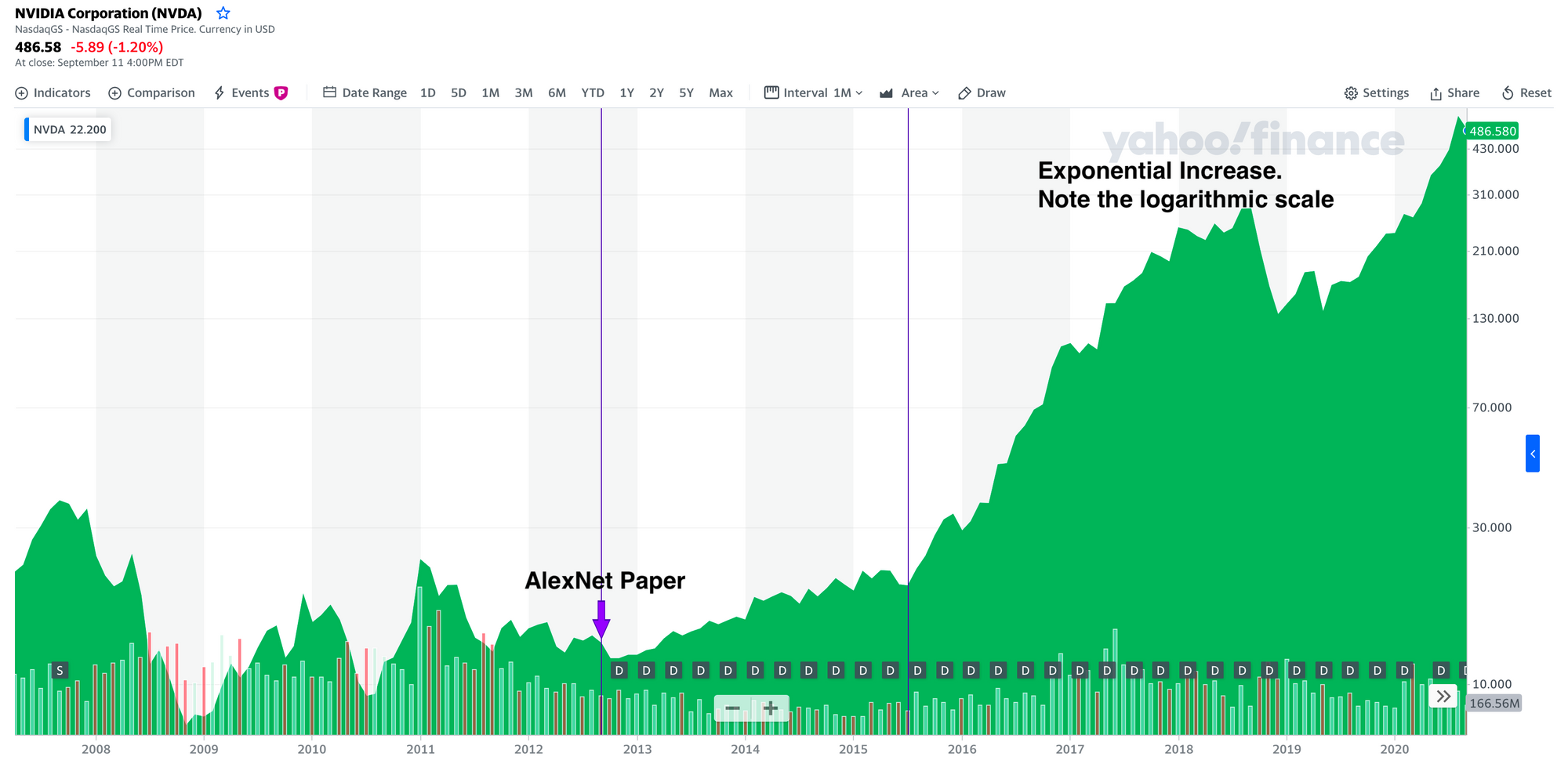

2012年には、トロント大学の大学院生であるAlex Krizhevsky(AlexNetの開発者)がCUDAを使用して、ImageNetのデータセット上に最初の本格的なディープラーニングモデルを作成しまた。ディープラーニングのアイデアは当時としてはそれほど新しいものではなかったが、その機能を実現するために必要な計算能力が不足していたために、実際には普及することはなかった。CUDAによって、Alexは元々ゲーム用に設計された計算能力を利用することができた。この論文は、AIのゲームチェンジャーとなり、現在の革命が始まった。

GPUとそのCUDAソフトウェアにより、NVIDIAは最新のAI革命の主要な貢献者となった。これらの企業にとって、AIにはかなり大きなビジネスチャンスがあることがすぐに明らかになった。もちろん、このことは市場でも注目されることはなかった。Nvidiaの株価は2015年から急騰した。2012年以降、Nvidiaの株価はナスダックコンポジットの380%に対して3500%(!)の成長を遂げている。

しかし、GPUのAIソフトウェア(CUDA)は、NvidiaのGPUでしか動作しない。つまり、AIはNvidiaのGPU専用ということになる。CUDAはNvidiaの商用牽引の強力な堀となった。基本的にAIのためのハードウェアの競争はない。このAI用GPUハードウェアの独占は、サーバー市場ではかなり顕著だ。GoogleはGPUの代替としてTPUを開発した。それらはGoogleのクラウド上で利用できるが、かなり高価だ。実際に手を出すことはできない。

AI研究者のほとんどは、研究用にコンシューマー向けのNvidia GPUを使っている。これらは、ゲーミング市場でのAMDとの競争のおかげで安くなっている。AWSのようなクラウド・プロバイダーは、私たちのウェブのほとんどを供給しているが、GPUについてはNvidiaに代わるものを提供していない。Nvidiaがサーバー向けのGPUに大幅なマージンを載せることができるのは、競争相手がいないからだ。これらはすべて、Nvidiaや株主にとっては朗報だが、AI研究者やエンジニアにとってはそうではない。

Nvidiaの商業的利益は、CUDAが競合他社のGPUで動作することがないことを意味している。これは、NvidiaがオープンソースのLinuxオペレーティングシステムへのGPUの統合に抵抗した理由でもある。2012年、Linuxのメンテナであり、オープンソース運動の守護聖人であるLinus Torvalds(そして口が悪いことでも知られている)は、有名なことに、NvidiaをLinuxコミュニティが取引した中で最も最悪の会社と呼び、公に「Nvidia、ふざけんな」(Nvidia, F**k you.)と言った。

Image via Nvidia