Graphcore AIチップの彗星

Graphcore(グラフコア)は2016年に創業されたAIチップのIntelligence Processing Unit (IPU)を開発する英国のセミコンダクター企業。GrpahcoreはAIチップを設計する新興企業の中でも最も速い勢いで資金調達を行っている。2020年6月時点の企業価値は約19.5億ドル。

要点

Graphcore(グラフコア)はAI(人工知能)チップのIntelligence Processing Unit (IPU)を開発する英国のセミコンダクター企業。創業4年で評価額は19.5億ドルに到達。投資家にはAI界の著名人や一流の投資会社、起業が名を連ねており、巨額の開発費を捻出できる大手企業が有利な市場の中で、新たな半導体のガリバーになることが期待される。

GPUの台頭とAIチップの誕生

半導体はソフトウェアよりもはるかに開発コストが高く、最近まで急進的なイノベーションが既存のプレイヤーを淘汰する余地はほとんどどない業界だった。長い間続いた競争のせいで、新興企業は極めて薄い利益率を強いられ、インテルのような既存業者に押し出された。インテルは四半世紀以上マーケットシェア首位をとっている。

しかし、地殻変動が起きている。いわゆるAIチップだ。最初にその有用性を認められたのはGPUだ。スタンフォード大学のアンドリュー・ウン教授による「Googleの猫」の裏側では、GPUを利用した機械学習が大きな効力を発した。その結果、機械学習の国際学会の前には世界中のGPUリソースが逼迫状態になるほど、GPUはこの領域で欠かせないインフラになった。NVIDIA CEOのJensen Huangは「AIはソフトウェアを飲み込んでいる(AI Is Eating Software)」と表現し、「AIの時代はGPUの時代(The Era of AI Computing – The Era of GPU Computing)」と主張した。

だが、ドメイン特化型アーキテクチャ(DSA)の潮流の中で、ニューラルネットの学習に特化したチップの開発に大きな金脈があることが嗅ぎつけられるのに時間はかからなかった。

Googleは2018年5月に「TPU(Tensor Processing Unit)」を発表。基本的にはクラウドからの利用を提供し、外販はしない。Googleは、各クラウドTPUは最高180テラフロップのパフォーマンスを出し、最先端の機械学習モデルを訓練して実行するための計算力を提供する、とうたっている。傘下のDeepMindは驚異的な学習速度を達成した「Alpha Go Zero」のレポートでTPU採用の効果に触れている。

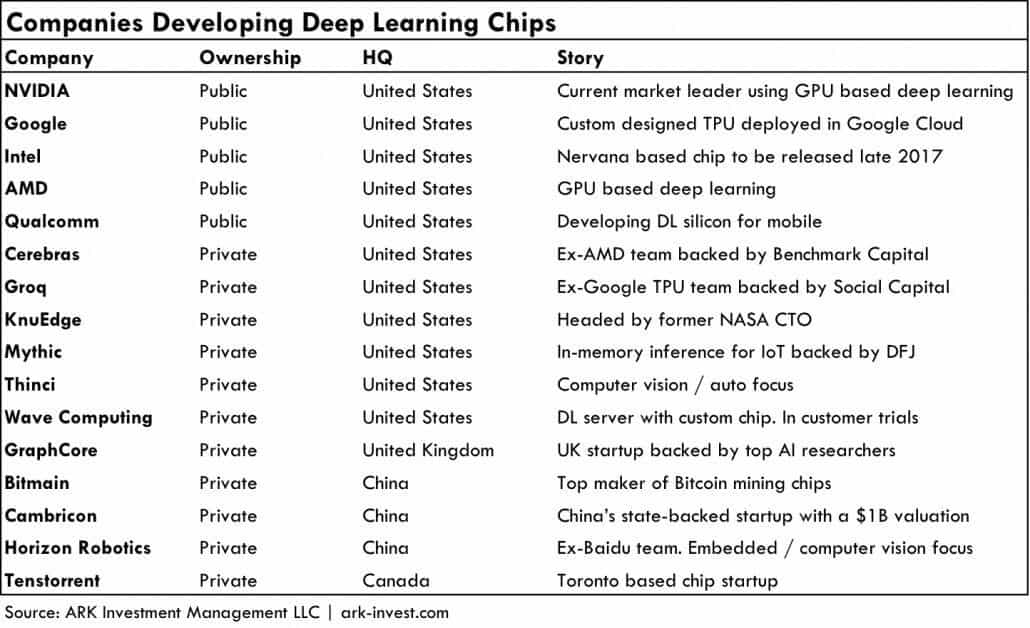

同時にAI特化の半導体スタートアップが雨後の筍のように出現した。新しいアーキテクチャを採用したチップは、NVIDIAのGPUを上回るパフォーマンスに挑戦し始めた。AIチップの開発企業は以下の通りで、Bitmainというビットコインの最大マイナーかつASICメーカーまで参入している。

巨大企業とスタートアップが肩を並べる「戦国時代」が始まった。なかでも、Grpahcore(グラフコア)は出色のAIチップ新興企業である。同社は他の新興企業と比べ最も速い勢いで資金調達を行っている。

Graphcoreの驚異的な成長

Graphcoreは2016年に創業されたAI(人工知能)チップのIntelligence Processing Unit (IPU)を開発する英国のセミコンダクター企業である。企業価値は2020年6月時点で約19.5億ドルに到達している。

GraphcoreのIntelligent Processing Unit(IPU)は、マシン・インテリジェンスの開発者にとって、代替プロセッサの10~100倍の性能を発揮する、真のゲームチェンジャーであると同社は自負している。IPUを利用することで、マシン・インテリジェンス・モデルのトレーニングは、数日から数週間ではなく数分で実行できるようになることが約束されている、と同社は主張している。

2016年、Graphcoreは「Poplar Software Stack」と呼ばれるマシンインテリジェンス向けに設計された世界初のグラフツールチェーンを発表。2017年7月20日、Graphcoreは「16 nmの超並列、混合精度浮動小数点プロセッサ」であるColossus GC2と呼ばれる初のチップを2018年に初公開した。 Graphcore C2 IPUと呼ばれる単一のPCI Expressカード上に2つのチップでパッケージ化されており、TensorFlowなどの標準的な機械学習フレームワークと連携してGPUと同じ役割を果たすことが予定されている。

ディープニューラルネットのような機械学習アプリケーション向けのIPUは、大規模並列の浮動小数点演算が可能で、CPUやGPU、さらにはGoogleのTensor Processing Unitよりもはるかに高い演算密度を提供する、と同社は主張している。

Graphcoreは、Tensorflow、MxNet、Caffe2、PyTorchなどの主要な機械学習フレームワークをサポートするPoplar C++グラフフレームワークソフトウェアを中心とした開発者およびパートナーコミュニティを構築した。Poplarフレームワークは、グラフ処理を行うIPUハードウェアから、グラフベースの機械学習開発プロセスを抽象化する。これにはオープンソースのグラフライブラリが含まれているので、TensorflowやMXNetのような機械学習フレームワークを使用している既存のユーザーアプリケーションは、IPU上ですぐに動作する。

この会社の投資家は同社の未来を約束しているように見える。Demis Hassabis(DeepMind)、Greg Brockman(OpenAI)、Ilya Sutskever(OpenAI)、Pieter Abbeel(UC Berkeley/OpenAI)、Scott Gray(OpenAI)、Zoubin Ghahramani(ケンブリッジ大学、Uberのチーフサイエンティスト)などのAIの著名人たちが投資を行っている。Hassabisはステートメントで次のように説明している。「一般的な人工知能が可能なシステムを構築するということは、生データから学習し、その学習を幅広いタスクに一般化できるアルゴリズムを開発することを意味します。これには多くの処理能力が必要ですが、Graphcoreのプロセッサを支える革新的なアーキテクチャには大きな期待が寄せられています」。

Graphcoreのブログ「PRELIMINARY IPU BENCHMARKS」によると、Graphcoreは「IPUは現在と将来の機械学習作業の双方に前例のないレベルのパフォーマンスをもたらす新しいAIアクセラレータ。大規模にマルチタスクを並列実行するコンピューティングと、IPU内または複数のIPU間の同期、革新的なデータ交換ファブリック、および大量のオンチップSRAMの独自の組み合わせにより、幅広い機械学習アルゴリズムにわたる訓練と推論の両方における見違えるような能力を提供する」と説明している。

- 「デナード・スケーリング」という法則に沿って高密度化と高速化が進んできたが、その法則に陰りがみられる

- ニューラルネットワークの学習には多量のメモリが必要であり、ここがボトルネックになるとしている

- GPUはゲーミングに最適化されたものであり、次世代の機械学習にとって最適ではない

- 人間の脳のアナロジーから、プロセッサーのコアがインターコネクトすることが重要だ

GraphcoreのJamie Hanlonのブログによると、メモリを従来のプロセッサに組み込むことは、はるかに低い電力消費で巨大な帯域幅を開くことによってメモリボトルネックの問題を回避する1つの方法になる。しかし、オンチップメモリは高価であり、DNNを訓練しデプロイするため現在使用されているCPUとGPUプロセッサのなかに、外部にあるメモリを追加することはできない。

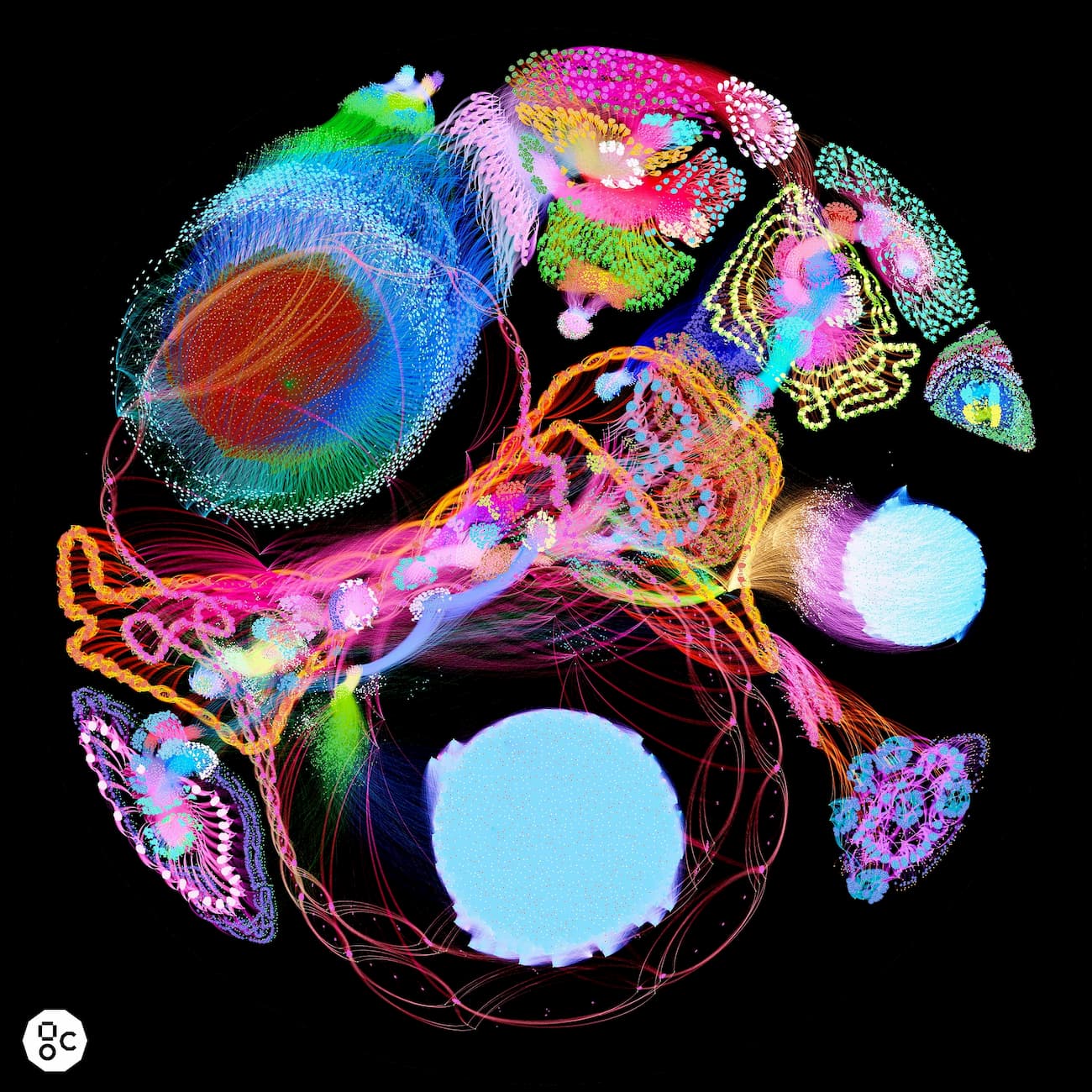

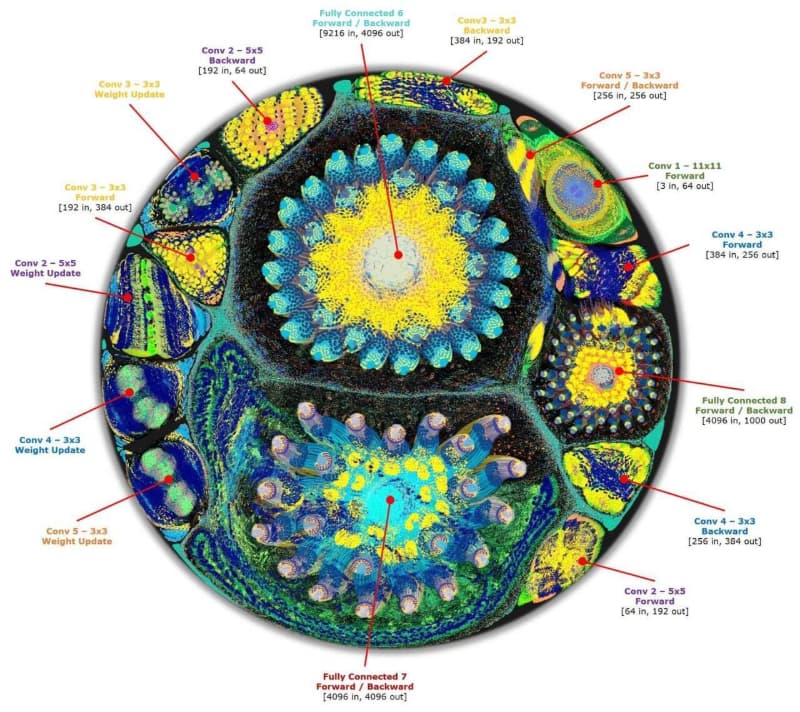

Toonらは人間の脳と同じ働きをするようなコンピューティングに未来を感じており、畳み込みニューラルネットワーク(CNN)の働きを以下のようにビジュアライズしている。

GPUを上回るAIアクセラレーション

IPUシステムは多層の畳み込みニューラルネットワーク(CNN)でのトレーニングで現存する、あらゆるチップでの学習を上回る成果を出せるとGraphcoreは主張している。「IPUシステムを使用することは既存のテクノロジーを大幅に上回るパフォーマンスをもたらす」というのだ。RESNET−50の学習における、300W GPUアクセラレータ(C2アクセラレータと同じ電力バジェット)で報告される最高のパフォーマンスは約580画像/秒だが、IPUのパフォーマンスは大きくそれを上回る。

すべての再帰的ネットワーク(Recurrent Neural Network)には、現在のチップアーキテクチャの課題であるデータ依存性が含まれている。データの依存関係により、使用可能な並列処理の量が制限される。 IPUおよびPoplarライブラリは、大量のオンチップメモリの可用性と、IPU内での計算およびデータ移動の柔軟性によって、これらの制限をよりよく処理する。

推論を実行するサーバでは、レイテンシ制約、すなわち、結果を得るまでの推論の要求からの最小の所要時間がある。以下の表は、GPUと比較して、さまざまなレイテンシ制約に対する単一レイヤロングショートタームメモリーネットワーク (Long Short-Term Memory Network)の推論のパフォーマンスを示している。Graphcoreの主張では差は歴然たるものだ。

Graphcoreは近くIPUの提供を開始する予定である。また、Graphcoreの投資家の並びは、ビジネスサイドにもその商機を納得させるものといっていい。

創業者は連続起業家のチップデザイナー

現CTOのSimon KnowlesとCEOのNigel Toonが2016年にGraphcoreを創業した。

SimonはGraphcoreの共同創立者であり、CTO兼エンジニアリング担当EVPであり、「Colossus」IPUのオリジナルアーキテクトでもある。 彼は30年以上にわたり、エマージェントワークロード用のオリジナルプロセッサを設計しており、2012年からはインテリジェンスに焦点を当てている。 Graphcoreの前には、2000年にBroadcomに買収されたElement14と2011年にNvidiaに買収されたIceraという2つのプロセッサ会社を共同設立して成功を収めた。

NigelはGraphcoreを設立する前に、VCが支援するシリコン企業2社のCEOを務めた。Picochipは2012年にMindspeedに売却され、最近ではXMOSを設立した。3Gセルラーモデムチップの会社Iceraの共同創業者であり、セールスとマーケティングを率い、取締役を務めていた。Iceraは2011年に4億3500万ドルでNVIDIAに売却された。Iceraの前は、Altera Corporationのバイスプレジデント兼ゼネラル・マネージャーとして13年間勤務し、年商4億ドル以上に成長した欧州ビジネス・ユニットの立ち上げと構築を担当した。2017年に買収されるまでImagination Technologies PLCの非常勤取締役を務め、3つの特許を保有している。

中国の対抗馬Cambricon

Graphcoreと同様注目をあつめるのが、中国のCambricon Technologies(寒武纪科技)である。Cambriconは10億デバイスで自分たちのAIプロセッサを搭載し、3年間で中国のハイパフォーマンスAIチップ市場の3割をつかむという強気の目標を掲げている。

中国の科学技術省が人口知能を含む革新的なプロジェクトに対して、長期的に積極的な投資を行うことを宣言しているが、Cambriconはその流れの中で中国政府系ファンドやアリババから1000万元の出資を受け、すでに企業価値が10億ドルを超えるといわれる。

Cambriconもニューラルネットワークの学習においてNVIDIAのチップをまさる効率を提供できると喧伝する。HuaweiのKirin 970チップは、最新の旗艦スマートフォン「Mate 10」のために開発されたもので、Cambriconの知的財産(IP)を使用している。 Cambriconの技術は国有企業Sugon Information Industryによって開発されたサーバーでも使用され、より高速なコンピューティングとより良い推論機能を提供していると主張されている。

雨後のタケノコ

他にもAIチップスタートアップは多数存在し、中にはステルスのまま補足されていないものもあるかもしれない。

2010年創業のカルフォルニアのWave Computingは合計8000万ドルの資金を調達している。同社は特許取得済みの「データフローアーキテクチャ」は「CPUやGPUの必要性を排除し、従来のディープ・ラーニング・ソリューションで見られる典型的なパフォーマンスとスケーラビリティのボトルネックを排除する」と説明。GPUに対して1000倍のニューラルネットの学習速度を提供できると主張している。

KnuEdgeは昨年ステルスから突然業界に現れたが、彼らは秘密主義の塊のような企業である。彼らのウェブサイトには従業員のプロフィール以外の情報がありません。VentureBeatの記事によれば、KnuEdgeは既に収益を上げており、いままで調達した1億ドルに加え、今年より多くの資金を調達することを検討していたことがわかっている。

Horizon Roboticsは年初のCES 2017でIntelと提携しAdvanced Driver Assistance System (ADAS) を発表。Mideaと提携し、インテリジェントエアコンディショナーを発表した。ホームセキュリティの問題を解決するという用途は極めて新しい。同社はBrain Processing Unit(BPU)と呼ばれるAIチップを開発している。

トロントのTenstorrentは2016年に設立され、「深い学習とスマートハードウェア向けに設計された次世代の高性能プロセッサASIC」を創出するために、未公開のシード調達をした。彼らのチームはNVIDIAやAMDの卒業生で構成されている。この隠密なスタートアップについてはあまり知られていない。

カリフォルニアのThinCIは、2010年に設立され、すべての機器にビジョン処理をもたらす技術を開発するための資金を調達している。スマートデバイスが、クラウドとの定期的な通信を必要としないでコンピュータビジョンなどの機能を持つ能力は「エッジコンピューティング」または「フォグコンピューティング」と呼ばれている。それがThinCIがプレーしたい場所である。

参考文献

Matt Fyles. "INSIDE AN AI 'BRAIN' - WHAT DOES MACHINE LEARNING LOOK LIKE?" Graphcore. 2017.

Nigel Toon. "BIG NAMES IN MACHINE INTELLIGENCE JOIN GRAPHCORE’S NEW $30 MILLION FUNDING ROUND" Graphcore. 2017.

※初稿は2018年11月に執筆、2020年5月22日に改稿。

Image Via Graphcore.ai