再犯予測アルゴリズムが示した公平性のトレードオフ

米国の一部の州では、再犯予測アルゴリズム「COMPAS」が使用され、裁判を待っている被告人を保釈するには危険すぎるかを決定するようになった。場合によっては、黒人が白人よりも、高リスクとして誤って分類される可能性がかなり高い。これがアルゴリズムの「公平性」をめぐる議論を引き起こした。何を持って公平と呼べばいいか。

要点

米国の一部の州では、再犯予測アルゴリズム「COMPAS」が使用され、裁判を待っている被告人を保釈するには危険すぎるかを決定するようになった。場合によっては、黒人の被告人が白人の被告人よりも、高リスクとして誤って分類される可能性がかなり高いとされている。これがアルゴリズムの「公平性」をめぐる議論を引き起こした。私たちは何を持って公平と呼べばいいのだろうか。

再犯予測アルゴリズム

COMPASは被告が再犯者になる可能性を評価するために米国の裁判所が使用するNorthpointe(現在のEquivant)が開発および所有する意思決定支援ツールである。Compasは「Correctional Offender Management Profiling for Alternative Sanctions」(代替制裁のための犯罪者矯正管理プロファイリング)の略だ。

COMPASは、告訴された犯罪者の再犯の可能性を推定するリスク評価アルゴリズムであり、保釈金の額の割り当てや判決の決定など、プロセスのあらゆる段階で裁判官の決定を支援するために、現在では一般的に使用されている。理想としては、これらのアルゴリズムは、個々の裁判官がより公平に正義を執行するのに役立ち、法廷制度全体の刑罰の不整合を根絶するのに役立つことが期待されている。

Northpointeは犯罪者の再犯可能性の評価のために、再犯、および公判前の不正行為に対するリスク尺度を作成し、使用すると説明する。アルゴリズムはリスクの算定に被告人の137項目のアンケートへの回答も活用する。

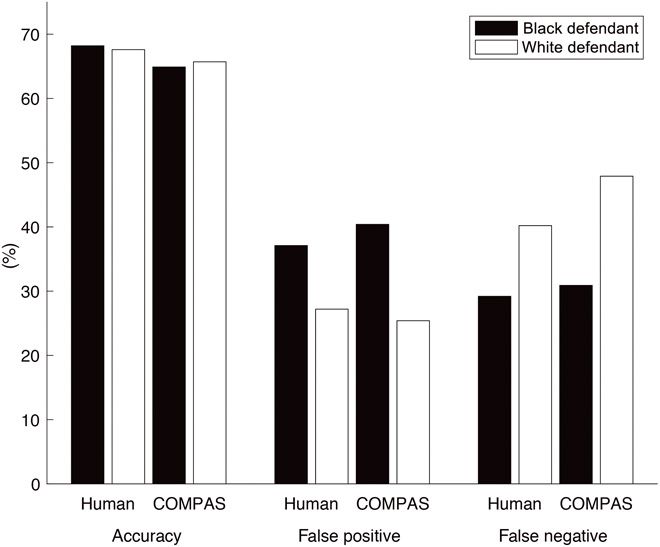

しかし、COMPASの黒人に対する偽陽性の確率の高さが俎上にあげられることとなった。ProPublicaのジャーナリスト、ジュリア・アングウィンは2015年にCompasのアルゴリズムにはアフリカ系アメリカ人へのバイアスが存在すると主張した。黒人の被告人は白人の被告人よりも、将来的に再犯しないのに誤って高リスクと分類される割合が高かった。アングウィンは白人と黒人の間の「偽陽性」の差異をバイアスの証拠とした。

さらに、ジュリア・アングウィンは、これらのリスク評価に依存している裁判官は、通常、スコアがどのように計算されるかを理解していないため、効果的に質問したり、その固有のバイアスを特定して修正したりすることができないことを発見しました。

これに対し、Northpointeは、さまざまな学者とともに、ProPublicaの分析に疑問を呈した。彼らは、再犯のリスクが中程度または高いと予測した被告人は、人種に関係なくほぼ同等の割合で再犯しているため、実際には公平であると主張している。COMPASの真の陽性率は人種的に中立であるように見える。

公平性をどう定義するのか?

他の専門家は、この議論は「公正の定義」にかかっており、NorthpointeとProPublicaの両方が設定した基準を満たすことは数学的に不可能である、と指摘した。

代表的なのはスタンフォード大学大学院博士課程のSam Corbett-DaviesとEmma Piersonである。彼らはCompasが人種にかかわらず、正確に予測をしていると主張した。彼らは、アルゴリズムがふたつの集団に対して同程度に信頼でき、なおかつ一方の集団の方がもう一方よりも再犯率が高いとすれば、黒人が誤って高リスクと分類される確率は必然的に高くなってしまう、と指摘した。そうでなければそのアルゴリズムはふたつの人種に対して、公平に較正されていないことになる。白人と黒人で異なる評価を行なわなければならなくなるからだ。つまり、彼らは公共の安全を向上させることとアルゴリズムの公平性という一般的な概念を満たすことの間にはトレードオフがある、と主張した。

これは、アングウィンが主張した、偽陽性の偏りをアルゴリズムの不公平性の証拠とする主張の大元を否定したことにもなる。アルゴリズムを公平にした結果、人種間の偏りが生まれてしまうが、それを是正するには、アルゴリズムを「不公平」にしないといけないからだ。また、黒人被告人の全体的な再犯率は白人被告人よりも高いため、アルゴリズムが100%正確でない限り(これは実際には達成不可能)、NorthpointeとProPublicaの両方の公平性の定義を同時に満たすことは数学的に不可能である。そう、これはトレードオフだ。

なぜ、黒人の再犯率が高いかというと、逮捕時の年齢が若い。一般的に年齢が若いほうが再犯率が高い。だとすれば、黒人と白人に対して異なるモデルを適用すれば、黒人の偽陽性を白人のそれと同水準まで押し下げられる可能性があるが、最高裁判決によると、モデルは全集団に対し同程度正確でなければならない。合衆国憲法が規定する「法の下の平等」である。Compasは様々な制約の中で今のアルゴリズムの形を表現しているようだ。

しかし、次はアルゴリズムの公平性ではなくモデルの精度について疑問が提示された。これらのアルゴリズムが、公正かつ正確な方法で再犯を予測する上で、訓練を受けていない人間よりも優れているかどうかという、より根本的な問題を検討する、ということだ。

2018年のダートマス大学のJulia Dresselとカルフォルニア大学バークリー校教授(コンピュータ科学)のHany Faridらによるサイエンス誌に発表された研究は、COMPASは、刑事司法の専門知識をまったく持たない人々が行った予測と同程度の正確性または公平性のみを有するに過ぎない、と指摘した。COMPASは137の特徴のコレクションだが、Dresselらは、たった2つの特徴を用いた単純な線形分類器で同じ精度を達成でき、より洗練された分類器は予測精度や公平性を向上させない、と主張した。

NorthpointeはCOMPASの内部構造の詳細を明らかにしていないが、彼らの商業的利益を考えれば当然のことだ。しかし、Dresselらは、単純な線形予測器であるロジスティック回帰がCOMPASと同様の予測精度が得られることを発見した。COMPASの全体的な予測精度が65.4%であったのに対し、LR分類器は全体的なテスト精度が66.6%であった。この予測器は、予測の公平性の点でCOMPASと同様の結果をもたらす。

再犯の正確な予測の問題はCOMPASに限ったことではなかった。研究チームは、再犯を予測するための9つの異なるアルゴリズム・アプローチを評価し、9つのうち、COMPASを含む8つが正確な予測に失敗していることがわかった。さらに、9つのアルゴリズムのメタ分析では、すべてのアプローチで中程度の予測精度しか得られず、これらの手法は刑事司法の意思決定、特に予防的拘留の意思決定にのみ使用すべきではないと結論づけられている。

参考文献

- Jeff Larson, Surya Mattu, Lauren Kirchner and Julia Angwin. How We Analyzed the COMPAS Recidivism Algorithm. 2016. Pro Publica.

- Sam Corbett-Davies, Emma Pierson, Avi Feller, Sharad Goel, Aziz Huq. Algorithmic decision making and the cost of fairness. 2017. arXiv.

- Julia Dressel, Hany Farid. The accuracy, fairness, and limits of predicting recidivism. Science Advances 17 Jan 2018:Vol. 4, no. 1, eaao5580.

- デイビッド・サンプター「数学者が検証!アルゴリズムはどれほど人を支配しているのか? あなたを分析し、操作するブラックボックスの真実」

- Ed Yong, ”A Popular Algorithm Is No Better at Predicting Crimes Than Random People” The Atlantic, 2018.