NVIDIAのGPU確保が米テクノロジー企業の最優先課題に

NVIDIAのデータセンターAI向けのGPU需要が著しく、獲得競争が過熱している。大手テクノロジー企業のほか、新興企業も競争に参戦。独自の優位性を持つNVIDIAのチップの需要は来年以降も高止まりすると考えられている。

NVIDIAのデータセンターAI向けのGPU需要が著しく、獲得競争が過熱している。大手テクノロジー企業のほか、新興企業も競争に参戦。独自の優位性を持つNVIDIAのチップの需要は来年以降も高止まりすると考えられている。

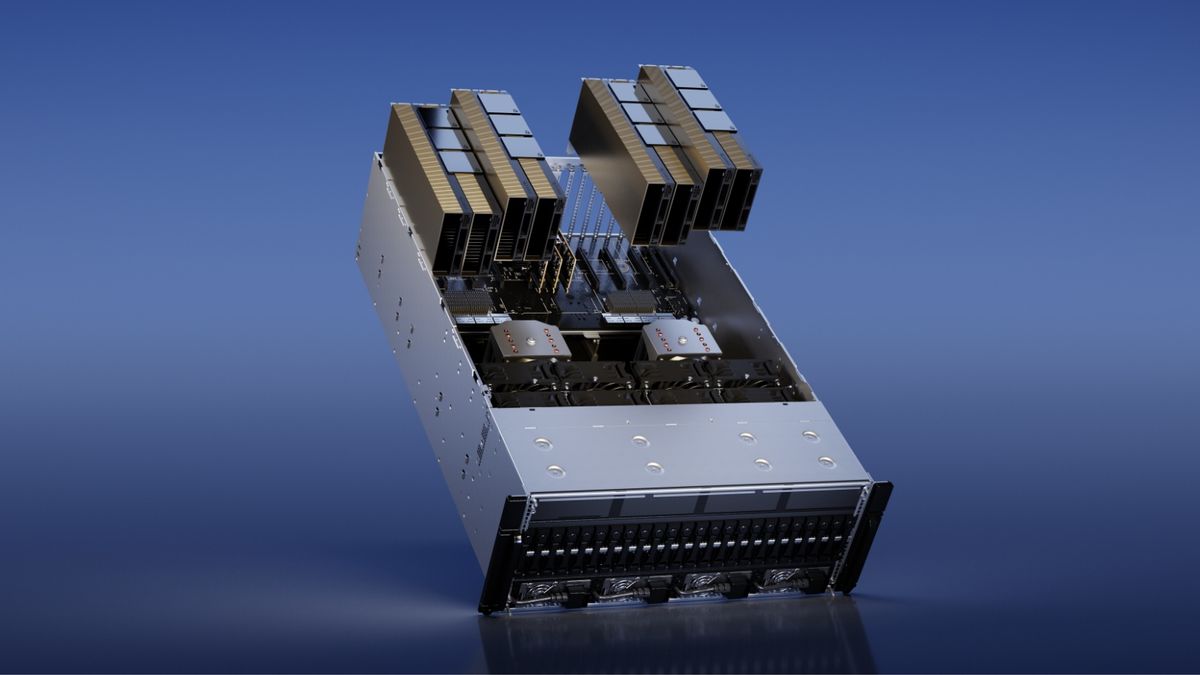

4日、決算説明会の場でソフトバンクの宮川潤一社長は、約200億円を投じ、生成AI基盤となるAIデータセンターを構築していると語った。NVIDIAのDGX Super Podで構成されたAIデータセンターは、経済産業省から53億円の助成を受け、2023年秋に稼働開始を見込んでいるという。これが日本最大規模のAI基盤になる予定だ。

ただし、これは現代のNVIDIA GPU獲得競争の(日本国内で観測できる)氷山の一角に過ぎない。

Microsoftは7月下旬の決算報告で、年次報告書のリスク要因を更新し、データセンター用GPUの確保の重要性について言及した。MicrosoftはAzureは保有するGPUの多くをOpenAIに貸していると見られ、OpenAIがGPT-5やそれ以外のAIの開発でより多くGPU需要を持っているはずだ。さらに社内の需要も存在するはずで、ことさらGPU供給の逼迫感を感じている可能性は高い。

Microsoftは、十分な容量を確保するために自社のデータセンター以外に目を向け始め、GPUをクラウドサービスとしてサードパーティの開発者に貸し出す、NVIDIAが出資するCoreWeaveと契約を結んだ。同時に、独自のカスタムAIプロセッサーの構築に数年を費やしてきた。ChatGPTに注目が集まったことで、Microsoftは自社チップの展開を加速させていると、米メディアThe Informationが4月に無名の情報筋の話を引用して報じた。Google、Amazon、Metaはいずれも過去10年間に独自のAIチップを発表している。

GPUの行き先は「シリコンバレー最大のゴシップ」

テスラの元AIディレクターで現在はOpenAIのAndrej Karpathyによると、NVIDIAのH100 GPUにアクセスできるかは、シリコンバレーの「最大のゴシップ」になりつつあるという。KarpathyはSNS「X」(旧Twitter)で、広く出回っているブログ記事を再共有し、「大小のクラウドプロバイダーにおける大規模なH100クラスタのキャパシティは底を尽きつつある」と推測し、H100の需要は最低でも2024年末までこの傾向が続くだろうと予想した。

ブログの著者は、OpenAIは50,000個のH100を、Inflectionは22,000個、Metaは25,000個を必要としていることを注記。加えて「大規模クラウドベンダー(Azure、Google Cloud、AWS、さらにOracle)はそれぞれ30,000個を欲しがるかもしれない」と推測している。さらにLambda LabsとCoreWeave、そしてその他のAIクラウドベンダーは、合計100,000個を望むかもしれない。Anthropic、Helsing、Mistral、Characterはそれぞれ10,000個を要するかもしれない、と 著者は書いている。

現状、LLMトレーニング(OpenAI、Anthropic、DeepMind、Google、イーロン・マスクのX.aiを含むすべての大手ラボが行っている)では、NVIDIAのH100に代わるものはない。各社がこのような投資をするということは、数年の減価償却の間、NVIDIA GPUがAI開発者にとって一定以上の有益さを保っているという推測が織り込まれていることを意味する。

さらにブログは各ベンダーの保有数について公開情報を組み合わせて以下のような推定を行っている。

- GPT-4は10,000~25,000個のA100でトレーニングされたと思われる。

- Metaには約21,000個のA100があり、Teslaには約7,000個のA100があり、Stability AIには約5,000個のA100がある。Falcon-40Bは384個のA100でトレーニングされた。

- Inflectionは、GPT-3.5相当のモデルに3,500機のH100を使用した。Inflectionの創業者ムスタファ・スレイマンは12月までに22,000個を運用し、現在では35,000個以上を運用している。

- GCPのH100は約25,000個。Azureはおそらく10,000~40,000のH100を持っている。AzureのキャパシティのほとんどはOpenAIに使われている。Oracleも似たようなもの

- 専業のCoreWeaveは3万5,000~4万の規模。

データセンターのAI化の可能性と制約には、NVIDIAのAIチップ独占が深く関与している。半導体業界コンサルティング会社SemiAnalysisの分析によると、(株価急騰の原因となった)NVIDIAのデータセンター部門の売上の急成長は、GPU 以外のサーバーの購入が減ったことが直接の要因と考えられる。AIへの投資シフトにより、従来のCPUの売上が弱くなり、IntelからNVIDIAに予算が流れているということだ。NVIDIAは最新のAI応用に必要不可欠となっているDGX H100を約27万ドルで販売している(1個あたりの粗利益はほぼ19万ドルで6割超とSemiAnalysisは推定している。儲かるはずだ)。

世界はGPUを担保にカネを借りられる時代を迎えている。AIクラウド専業の CoreWeave は、23億ドルの債務枠を確保した。この資金調達は 大手ヘッジファンドのブラックストーンら大手が主導し、AI コンピューティングで需要の高いH100 チップが担保となっている。これは「GPUを担保に借金し、GPUを買って担保にし…」という、「土地転がし」ならぬ「GPU転がし」が可能な時代に突入したことを意味する。