全米の警察が"誤ったデータ"から犯罪予測AIを訓練していた

犯罪予測アルゴリズムは、アメリカ全土の都市で一般的になってきている。大手ベンダーの製品である「PredPol」は不釣り合いなほどに、人種的マイノリティ、英語を母国語としない人、LGBTQの人を標的にし、女性に対する暴力への対処を怠っていた。汚れたデータによるAIのトレーニングが誤った思想を警察に植え付けていた。

要約

犯罪予測アルゴリズムは、アメリカ全土の都市で一般的になってきている。大手ベンダーの製品である「PredPol」は不釣り合いなほどに、人種的マイノリティ、英語を母国語としない人、LGBTQの人を標的にし、女性に対する暴力への対処を怠っていた。汚れたデータによるAIのトレーニングが誤った思想を警察に植え付けていた。

汚れたデータの仕様が蔓延

2010年5月、一連の有名な不祥事を受けて、ニューオーリンズ市長は米国司法省に市の警察局(NOPD)の調査を依頼した。10ヶ月後、司法省はその衝撃的な分析を発表した。2005年以降の調査期間中、NOPDは繰り返し憲法と連邦法に違反していた。

司法省は、2005年以降の見直し期間中、NOPDは憲法や連邦法に違反する行為を繰り返していた。黒人住民に対して過剰な力を行使し、不釣り合いなほどに、人種的マイノリティ、英語を母国語としない人、LGBTQの人を標的にし、女性に対する暴力への対処を怠っていた。当時のトーマス・ペレス検事総長補佐官は、問題は「深刻で、広範囲で、制度的で、部署の文化の中に深く根ざしていた」と述べています。

不穏な調査結果にもかかわらず、同市はわずか1年後にデータマイニング会社のパランティア社と秘密の提携を結び、予測警察システムを導入した。会社と市政府の資料によると、逮捕記録や電子警察報告書などの過去のデータを使用して犯罪を予測し、公共の安全戦略を策定するのに役立つという。これらの資料では、司法省が明らかにした違反行為に対処するためにデータをクリーンアップしたり、修正したりする努力を示唆するものは一切ありませんでした。どう考えても、破損したデータはシステムに直接入力され、同課の差別的な慣行を強化していた。

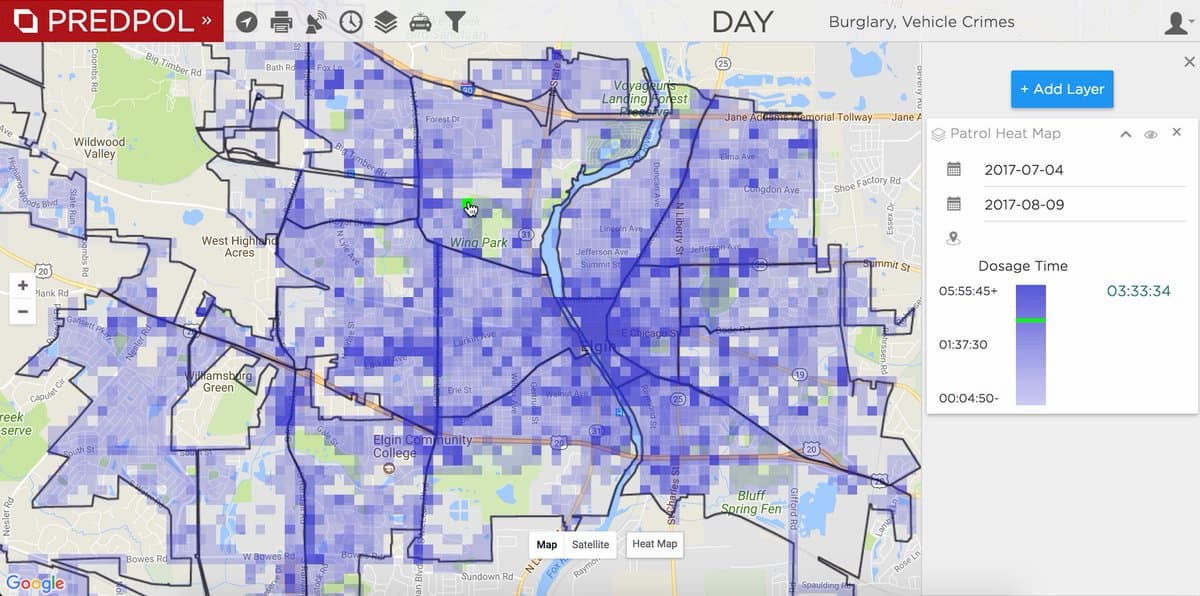

犯罪予測(予測的警察)アルゴリズムは、アメリカ全土の都市で一般的になってきている。透明性の欠如は、正確な統計として表すのは難しいが、大手ベンダーのPredPolはそれは33人のアメリカ人のうち1人を"保護"するのに役立つと自慢 している。このソフトウェアは、多くの場合、薄く引き伸ばされた警察署がより効率的な、データ駆動型の意思決定を行うのを支援する方法として売り出されている。

しかし、新しい研究では、これらのシステムを "汚れたデータ" で訓練しているのは、ニューオリンズだけではないことを示唆している。NYU Law Reviewに掲載される予定の本日発表された論文では、人工知能の社会的影響を研究する研究センター、AI Now Instituteの研究者が、この問題が調査した管轄区域の間で蔓延していることを発見した。このことは、刑事司法制度で使用されている予知取り締まりやその他のアルゴリズムの有効性に重大な意味を持つ。

AI Nowの共同設立者であり共同ディレクターであり、この研究の著者でもあるケイト・クロフォードは「システムは、訓練に使用するデータと同程度にしか優れていない」と論文内で指摘する。「データ自体が間違っている場合は、同じように過剰にトレーニングされ、しばしば人種的にターゲットを絞ったコミュニティに、より多くの警察のリソースが集中することになる。だから、実際には、これらのシステムを使用する人々は、彼らが何らかの形でより中立的または客観的であると仮定しているが、実際には、彼らは違憲性や違法性を伴った観念を植え付けている。これは一種の技術洗脳だ」。

研究者らは、予知型警察システムを使用し、政府の委託を受けた調査を受けた地域に焦点を当てて、13の管轄区域を調査した。後者の要件は、取り締まりの実践が法的に検証可能な文書化されていることを保証するものであった。9つの管轄区域では、システムが「汚れたデータ」に基づいてトレーニングされていたという強い証拠が見つかった。

問題は、ニューオーリンズのように、マイノリティを不釣り合いにターゲットにしたことでデータが歪められているだけではなかった。いくつかのケースでは、警察署は公式の犯罪率を下げようとする激しい政治的圧力の下で、意図的にデータを操作したり、改ざんしたりする文化を持っていた。たとえば、ニューヨークでは、犯罪統計を人為的に誇張するために、署長が定期的に犯罪現場の被害者に苦情を出さないように頼んでいた。警察官の中には、検挙数のノルマを満たすために無実の人々に麻薬を仕込んだ者もいた。現代の予測警察システムでは、犯罪を予測するために機械学習に頼っているが、これらの破損したデータポイントが正当な予測因子となる。

この論文の発見は、予測警察システムの妥当性に疑問を投げかけていることだ。このようなソフトウェアのベンダーは、そのツールの偏った結果は簡単に修正できると主張することが多いという。しかし、これらすべてのケースで、データに反映されている何らかのシステム的な問題がある。そのため、改善策としては、単に悪い行動の1つや2つの例を取り除くだけでは不十分だ。良いデータと悪いデータを分離したり、良い警官と悪い警官を分離したりすることはそう簡単ではない。

ベンダーはまた、薬物関連の検挙者のような偏りを反映する可能性の高いデータを避け、代わりに911コールのようなトレーニング入力を選ぶと主張している。しかし、研究者たちは、より中立的と思われるデータにも同じように多くの偏りがあることを発見した。さらに、ベンダーはシステムに入力されたデータを独自に監査していないことも判明した。

汚れたデータを生み出すメカニズムの改革が必要

この論文は、公判前の審理中の被告人の運命から判決の厳しさまでを決定するために機械学習を使用している犯罪リスク評価ツールの使用をめぐって、米国で起きているもう一つの議論に光を当てている。このアルゴリズムは刑事司法制度全体で使われている。

現在のところ、多くの議論の焦点は、システム自体の仕組み、つまり数学的に公平な結果が得られるように設計できるかどうかにあった。しかし、研究者たちは、これは間違った質問だと強調している。「アルゴリズムの問題を、それが関係している社会システムやその中に組み込まれている社会システムから切り離しても、あまり意味がない。私たちは、バイアスに対処するための数学的、計算ベースのこの種の試みの限界を本当に認めなければならない」と論文は指摘している。

研究者たちは、この研究が、ツールそのものではなく、より広範なシステムに焦点を当てるための議論の再構築に役立つことを期待している。また、同研究所が昨年発表したアルゴリズムによる影響評価のフレームワークのように、自動化された意思決定ツールの使用に透明性、説明責任、監視をもたらすメカニズムを政府に促すことも期待している。

汚れたデータを生み出す社会的・政治的メカニズムを改革しなければ、そのようなツールは良いことよりも悪いことの方が多いと彼らは言う。人々がそれを認識すれば、おそらく議論は最終的に「機械学習やその他の技術の進歩を利用して、実際に犯罪の根本原因を止める方法」にシフトするかもしれない。政府のデータを使えば、貧困や失業、住宅問題をより有益な方法で解決できるかもしれない。

参考文献

Rashida Richardson et al. Dirty Data, Bad Predictions: How Civil Rights Violations Impact Police Data, Predictive Policing Systems, and Justice. 94 N.Y.U. L. REV. ONLINE 192 (2019).