DeepMind研究者が"反植民地的AI"の概念を提唱

グーグルのDeepMindとオックスフォード大学の研究者たちは、AIの実践者たちが脱植民地主義に基づいて業界を改革し、アルゴリズムによる更なる搾取や抑圧を回避することを推奨する。「反植民地的AI」の概念は、AIによって影響を受けた人々からのフィードバックを含めることの重要性を強調する研究の増加に基づくものだ。

要点

グーグルのDeepMindとオックスフォード大学の研究者たちは、AIの実践者たちが脱植民地主義に基づいて業界を改革し、倫理原則を実践に落とし込み、アルゴリズムによる更なる搾取や抑圧を回避することを推奨している。この「反植民地的AI」の概念は、AIシステムによって最も影響を受けた人々からのフィードバックを含めることの重要性を強調するAI研究の増加に基づいている。

システムがどう権力をシフトさせるのかを問う必要性

研究者たちは、15日に発表されたプレプリント論文の中で、すでに使用されているAIの植民地主義と植民地形態を批判的に検証しながら、AIシステムを構築する方法を詳述している。この論文は、DeepMindの研究者であるウィリアム・アイザックとシャキール・モハメド、およびオックスフォード大学の博士課程の学生で、以前は国連事務総長のデジタル協力に関するハイレベルパネルのアドバイザーを務めていたDeepMindの倫理と社会のインターンであるマリー・テレーズ・プングが共同執筆したものだ。

研究者らは「権力は倫理的な議論の中心にあり、権力についての会話は、歴史的な文脈を含み、今日も権力のダイナミクスに影響を与え続けている植民地主義の構造的な遺産を認識しなければ、不完全なものになる」と主張している。研究者らはさらに、人種資本主義、階級間の不平等、異性愛的な家父長制などの不平等は植民地主義に根ざしており、そのような害を永続させないようにAIシステムを設計する際には、これらのパワー・ダイナミクスを認識する必要があると主張している。

未来の責任ある有益なAIを構築するためのあらゆるコミットメントは、過去から継承されたヒエラルキー、哲学、技術に私たちを結びつけ、現在の技術に新たな責任を負うことになる、と論文は指摘している。「これは、私たちの研究や技術開発を、確立された、そして新たに出現した倫理原則や規制とよりよく整合させ、イノベーションや科学的進歩の負の影響を受けることが多い脆弱な人々に力を与えるために必要なことだ」。

論文には、データの植民地化とデータ関係の脱植民地化を分析したり、1997年にフィリップ・アグレが提唱したAI開発への批判的な技術的アプローチを採用したりと、さまざまな示唆が盛り込まれている。

「反植民地的AI」の概念は、AIシステムによって最も影響を受けた人々からのフィードバックを含めることの重要性を強調するAI研究の増加に基づいている。先週初めにNature誌に発表された記事では、AIコミュニティはシステムがどのように権力をシフトさせるのかを問う必要があり、「無関心な分野は権力者に仕える」と主張している。

DeepMindの論文は、アルゴリズムの意思決定システムの中に植民地的な特徴がどのように見られるか、そして著者たちが「植民地性の所在(sites of coloniality)」と呼んでいるもの、つまり植民地的なAIを永続させることができる慣行を問うものである。これらには、不利な立場にあるコミュニティでのベータテストが含まれている。ケンブリッジ・アナリティカがケニアとナイジェリアでテストを行っているようなことや、あるいはPalantirがニューオリンズの黒人居住者をターゲットにして犯罪予測(予測的警察)を使用しているようなことが含まれている。また、データのラベリングやAIシステム開発のために低賃金労働者に頼る「ゴーストワーク」もある。ゴーストワークは新たなグローバルな下層階級の創出につながると主張する人もいる。

アルゴリズムの搾取、抑圧

著者らは、「アルゴリズムの搾取」とは、機関や企業がアルゴリズムを使用してすでに疎外された人々を利用する方法であり、「アルゴリズムの抑圧」とは、自動化やデータ駆動型の予測システムの使用を通じて、あるグループの人々を従属させ、別の人々を特権化することであると定義している。

G20やOECDのようなグループからの倫理原則は、AIナショナリズムやAI超大国としての米国や中国の台頭のような問題と同様に、論文の中で取り上げられている。

「グローバルなAIガバナンスの言説における権力の不均衡は、データの不平等やデータ・インフラの主権の問題を包含していますが、それだけではありません。私たちは、AIの規制規範や基準が誰を保護しているのか、誰がこれらの規範を投影する権限を与えられているのか、そして少数派が権力と資本の中央集権化から利益を得続けることによってもたらされるリスクについての疑問に立ち向かわなければならない」と、論文は記述している。著者らが推奨する戦術には、政治的なコミュニティ活動、批判的な技術的実践、植民地主義体制からの抵抗と回復の過去の事例の活用などがある。

リレーショナル倫理学の研究者であるアベバ・ビルハーン氏からパートナーシップ・オン・AIまで、AI倫理学コミュニティの多くのメンバーが、アルゴリズム・システムによって最も影響を受ける人々を開発プロセスの中心に置くよう機械学習の実践者に呼びかけている。この論文では、AIコミュニティにおける反ブラックネスに対抗する方法についての最近の論文、ルハ・ベンジャミンの廃人主義的なツールの概念、解放的なAIのアイデアと似たような概念を探っている。

著者らはまた、AIとコンピューティング・コミュニティの黒人メンバーがBlack Lives Matter(BLM)の抗議活動中に先月発表した公開書簡で表現された感情を取り入れており、AIの実践者に、自分たちの創造物が住宅、教育、ヘルスケア、雇用などの分野で人種差別や制度的抑圧を支援する可能性があることを認識するよう求めている。

参考文献

- Shakir Mohamed, Marie-Therese Png, William Isaac. "Decolonial AI: Decolonial Theory as Sociotechnical Foresight in Artificial Intelligence". arXiv:2007.04068. Submitted on 8 Jul 2020

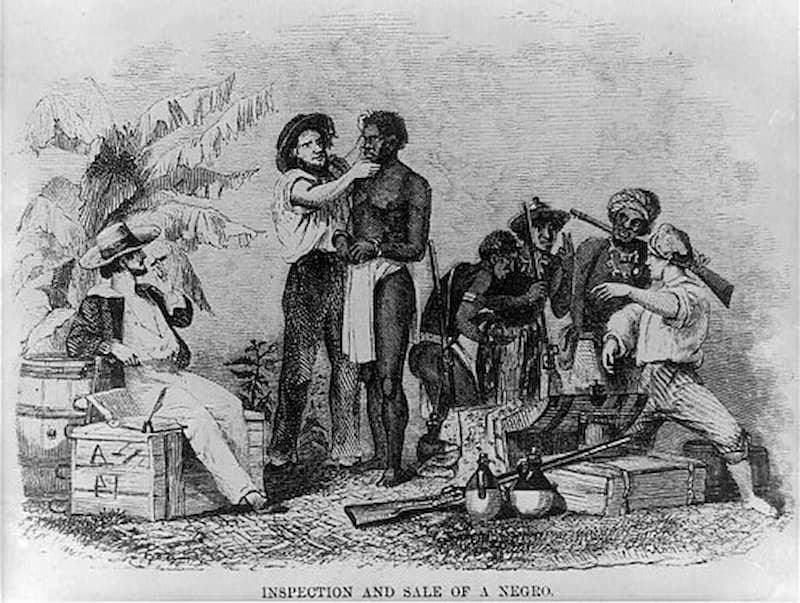

Photo by "The inspection and sale of a slave"by paukrus is licensed under CC BY-SA 2.0