オンデバイス生成AIの台頭 専用半導体が進化

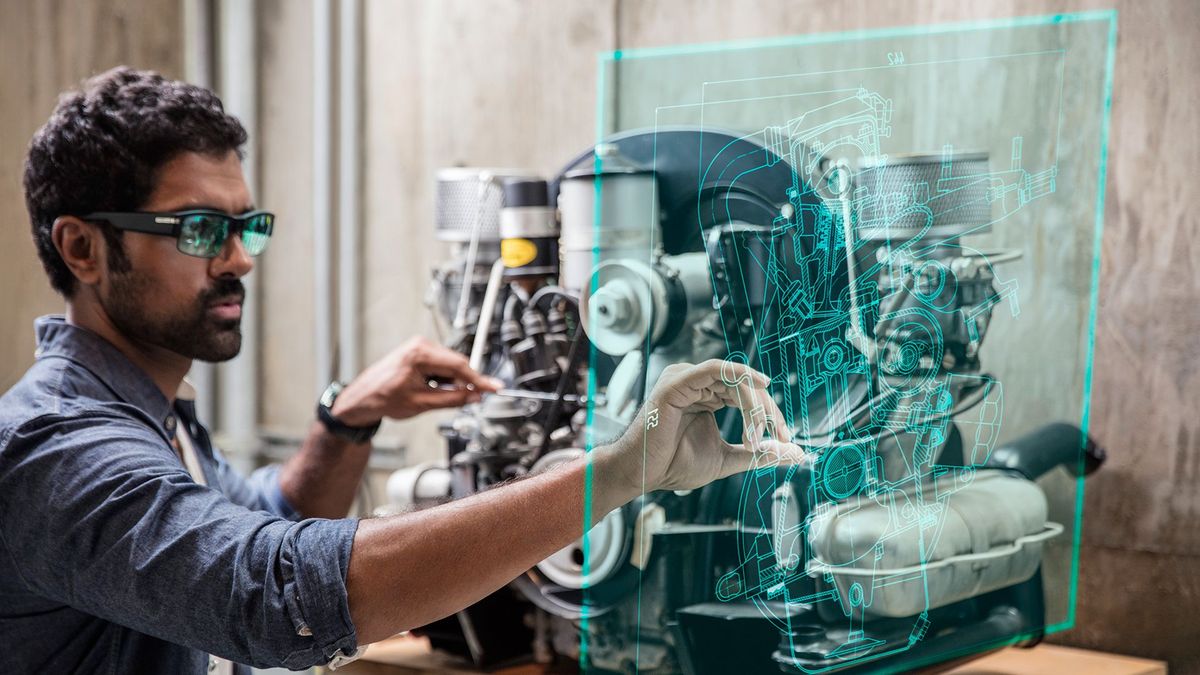

スマートフォン上で、データセンターとのやりとりがなくとも、ChatGPTのような言語AIや画像生成AIを動作させられることが当たり前になりそうだ。今後は自動車のようなソフトウェア制御の比重が高まる製品でも同様の変化が見られるだろう。

スマートフォン上で、データセンターとのやりとりがなくとも、ChatGPTのような言語AIや画像生成AIを動作させられることが当たり前になりそうだ。今後は自動車のようなソフトウェア制御の比重が高まる製品でも同様の変化が見られるだろう。

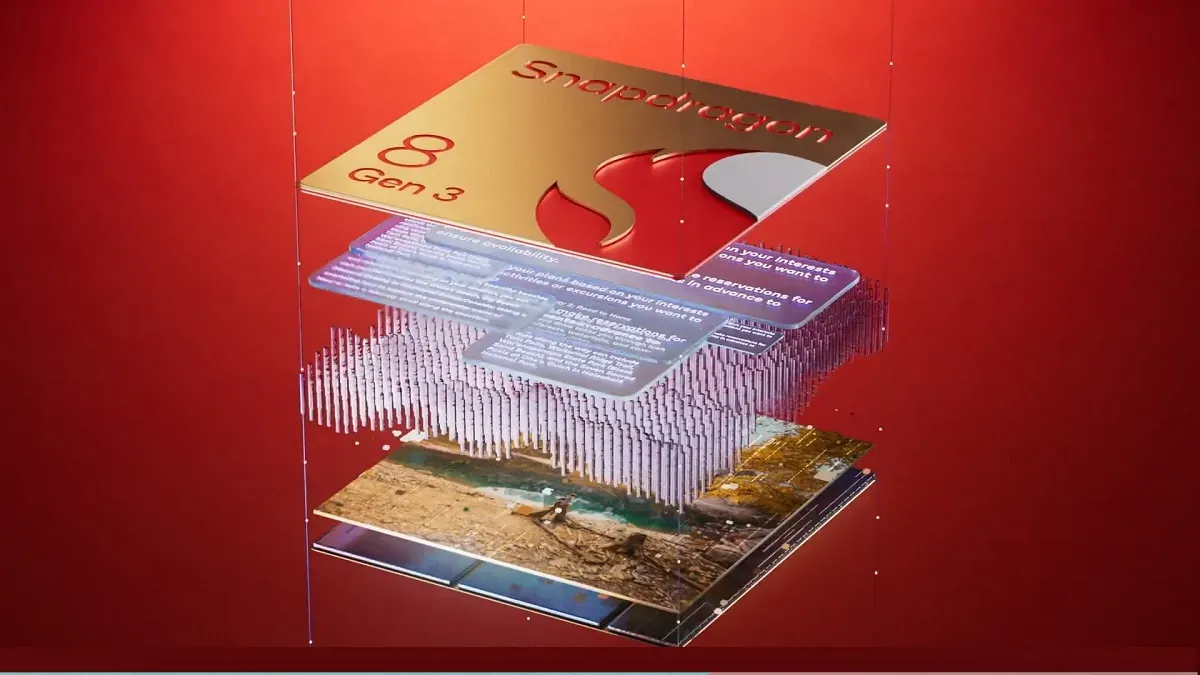

半導体大手クアルコムは、10月24~26日にハワイで開催された年次会議のSnapdragon Summitで、携帯電話向けシステムオンチップ(SoC)「Snapdragon 8 Gen 3」を発表した(*1)。この新しいSOCのハイライトの1つは、AIコンピューティングをデバイス上で実行できるようになったことだ。いわゆるエッジAIの成立である。チップメーカーの製品開発は、業界の趨勢を物語っているのかもしれない。

昨年のSnapdragon 8 Gen 2では、Sensing Hubを搭載したHexagonプロセッサとオンデバイス・パーソナライゼーションに焦点が当てられた。今年は、大規模言語モデル(LLM)、大規模視覚モデル(LVM)、トランスフォーマーネットワークベースの自動音声認識(ASR)の実行に焦点が当てられた。クアルコムは、最大100億のパラメータのLLMがオンデバイスでネイティブに実行されると主張した。

LLMモデルは、スマートフォン業界最速の20トークン/秒で動作する。トークンは処理できる言語の最小単位を指す。機械学習(ML)には学習と推論の二つの区分があるが、推論をクラウドに依存する必要がなくなることを意味する。

インターネットに接続しなくても、百度のERNIE 3.5からOpenAIのWhisper、メタのLlama 2、グーグルのGeckoまで、あらゆるものを携帯電話で実行できるようになる。また、クアルコムはマイクロソフトと提携して画像生成AI「Stable Diffusion」をサポートした。オンデバイス(デバイス上で)でStable Diffusionを展開するSnapdragon 8 Gen 3は、ネットに接続することなく、1秒未満で画像を生成できる。

これは、低消費電力のバッテリー駆動デバイス、つまり携帯電話の用途では素晴らしい能力と言えるだろう。クアルコムはPCに対しても同様のチップセットを発表しており、今後は自動車のようなソフトウェア制御の比重が高まる製品でも同様の変化が見られるだろう。

クアルコムはオンデバイスAIのパッケージを「Qualcomm AI Engine」とマーケティングしている。同社はSDKも提供しており、ソフトウェア開発を省力化したハードウェアベンダーの要請に応えている。それ以外にもPytorchやGoogleのTensor Flow Liteなどのライブラリ、フレームワークをサポートしている(下図)。

Snapdragon 8 Gen 3はハイエンドスマホ向けで、ソニーやASUS、OPPO、RedMagicなどの主要スマートフォンメーカーが、次世代のフラッグシップモデルに搭載を計画中という。シャオミの「Xiaomi 14 Pro」は11月中旬にすでに市場投入されている。OnePlusは12月5日に中国・深センで新たなフラッグシップスマホ「OnePlus 12」を発表する予定だ。

あっという間のオンデバイス展開

AIの技術革新の速度は目覚ましい。今年の2〜3月には、Llamaが公開されてからたった3週間で、オープンソース開発者がLlamaの比較的軽量なモデルのiPhone上での動作を報告していた。

このときは、オンデバイスLLMはStable Diffusionの瞬間を迎えた、という表現が飛び交った。Stable Diffusionは、同様に、一般人が基礎となるソースコードにアクセスすることで、自分のハードウェアで画像生成モデルを実行できるようにしたが、LLMでも個人のデバイスだけで実行可能となる瞬間を昨年12月のChatGPTの登場から3ヶ月程度で達成してしまった。

Googleの流出した内部文書によると、LLaMAの登場以降、それを基にしたオープンソースモデルが、GoogleのBardとOpenAIのChatGPTにあっという間に追いついたと主張されていた。

モバイルのSoCやソフトウェアがオンデバイスAIに最適化することで、オープンソースのグループにも大きなチャンスが巡るだろうか。

あと、これは2019年に書いた記事。エッジでの計算需要、特にAIが増え、データセンターからコンピューティングが分散していく、という予測である。

脚注

*1:SoCに搭載された「Qualcomm Hexagon NPU」のパフォーマンスは前世代から最大98%向上し、パフォーマンス/ワットが最大40%向上する、と同社はうたう。また、本機にはより小規模なニューラルネットワークや、文脈認識などの特定のアプリケーション向けの、非常に効率的なAIチップ「Qualcomm Sensing Hub」が別に搭載されており、AIパフォーマンスが最大3.5倍向上したと主張した。