NVIDIAのデータセンター向けCPU「Grace」とは

包括的なデータセンター・ソリューションの野望

要点

NVIDIAが発表した機械学習向けのデータセンター向けCPUは、NVIDIAのGPUとの相互接続性を確保する、パッケージ化を推し進める製品だ。データセンターの包括的なプラットフォーム提供者になろうとする野望が滲んでいる。

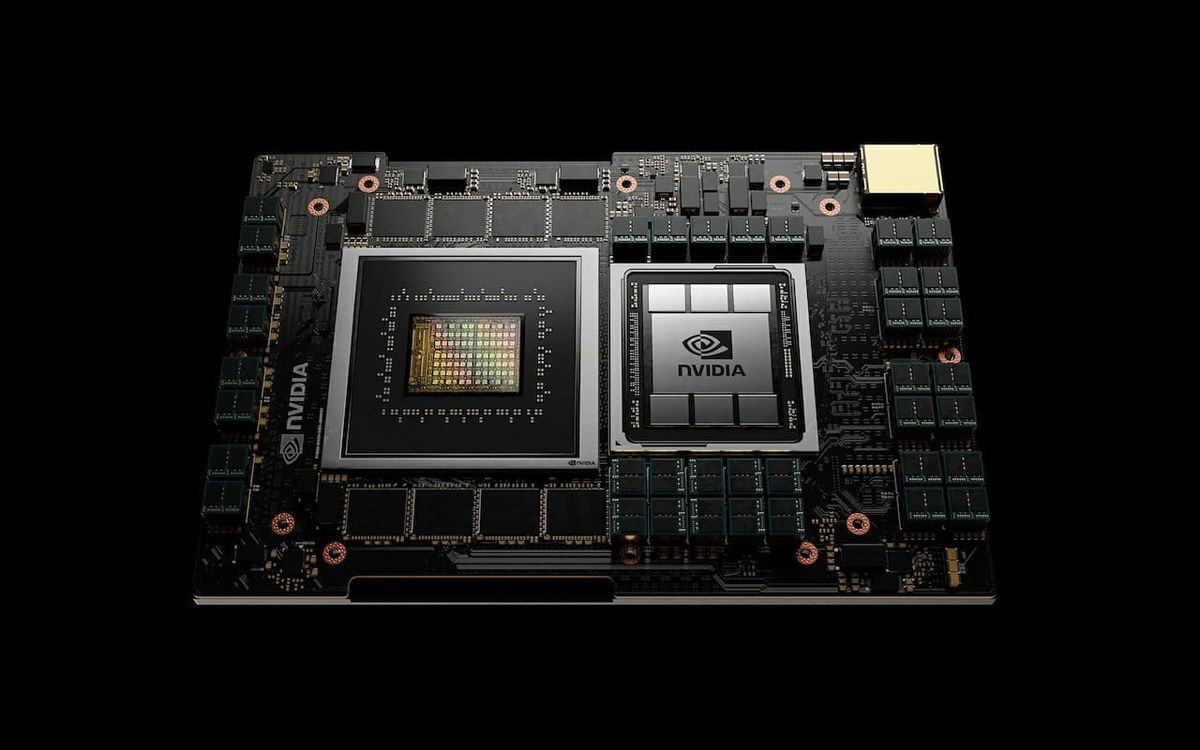

NVIDIAは12日から開催されているGTCで、初のデータセンター向けCPU「Grace」を発表した。

Graceは、1兆個以上のパラメータを持つ次世代自然言語処理(NLP)モデルのトレーニングなどを目的にした高度に特化したプロセッサ。2023年に市場投入される予定だ。Grace CPUベースのシステムは、NVIDIA GPUと緊密に結合することで、x86 CPUで動作する現在の最先端のNVIDIA DGXベースのシステムよりも10倍速いパフォーマンスを実現する、と同社はうたっている。

CPUは、初期設計のN1がすでに話題になっているArm社の次世代CPUコア「Neoverse」を採用するが、その性能については情報が少ない。

NVIDIAは、Intel XeonやAMD EPYCのサーバー市場を直接狙っているのではなく、GPUに直接接続し、補完するための独自のチップを構築し、膨大な1兆パラメータのAIモデルの処理を支援している。CPUとGPUの直接接続を実現するために、NVIDIAは、GPU間をシームレスに接続したマルチGPUシステムを作るための相互接続技術「NVLink」をCPUとGPUの通信に使用すると明らかにしている。最終的には、将来のNVIDIAサーバーGPUと連携して動作するように設計された、高性能かつ広帯域のCPUになるとのことだ。

近年の機械学習では、データ量とAIモデルのサイズが指数関数的に増加する傾向がある。典型的なのがNLP分野であり、2020年1月に発表されたOpen AIの研究者たちによる論文が「スケーリングの法則」を提唱すると、パラメータ数、データセットのサイズ、トレーニングに使用される計算量が膨れ上がり、人間のような文章を生成することで注目を集めたGPT-3のパラメータ数が1,750億に達したのもつかの間、最新のGoogle BrainのSwitch Transformerは、16兆個のパラメータに到達している。

これらをトレーニングするには、システムのボトルネックを解消するためにGPUと緊密に結合できる新しいCPUが必要だった、とNVIDIAは主張している。同社は、1兆個のパラメータを持つモデルの性能を10倍にすることを目指しており、NVIDIA謹製の64モジュールのGrace+A100システムの性能予測では、このようなモデルのトレーニングを1ヶ月から3日に短縮することができ、8モジュールのシステムで5,000億パラメータのモデルをリアルタイムで推論することも可能だ、と主張している。

スイス国立スーパーコンピューティングセンター(CSCS)とロスアラモス国立研究所は、Graceを搭載したヒューレット・パッカード社製のスーパーコンピュータを2023年に稼働させる計画だ。

声明の中のジェンスン・ファンCEOはこう語っている「NVIDIAは、ライセンスされたArmのIPを使用して、Graceを巨大スケールのAIおよびHPC専用のCPUとして設計した。GPUやDPUと組み合わせることで、Graceはコンピューティングのための第3の基盤技術を提供し、AIを進化させるためにデータセンターを再設計する能力を与えてくれる。NVIDIAは今や3チップ企業(編注:CPU、DPU、GPU)となった」。

これは同社が包括的なデータセンター・ソリューションを提供する野望を強調している。

包括的なデータセンター・ソリューションの野望

昨年、NVIDIAが400億ドルのArm買収を発表したことは、半導体市場に衝撃を与えた。買収の目的はいくつか推測されたが、有力なものは、同社のドル箱に育ったデータセンター事業の強化だった(詳しくはこちら)。

NVIDIAの主力事業は長らくゲーミングであり、他の事業部門を足し合わせてもゲーミング部門には敵わないという一本足の時期が創業からずっと続いてきた。しかし、近年はそのバランスが変化している。2016年7−9月期で2億700万ドルに過ぎなかったデータセンター事業の収益は、2020年10−12月期には19億300万ドルと9倍以上に成長した。2000年4−6月期にはゲーミング事業を一時的に追い抜いた。

これはGPUの機械学習利用が拡大していることを意味している。GPUを利用した訓練や推論の有効性が証明された2012年頃から機械学習向けの用途が急激に加速してきたが、近年はコンピュータ科学に軸足を持つ会社だけではなく、多種多様な企業が機械学習をビジネスに取り入れ始めたため、この分野への投資で突出してきたNVIDIAはその恩恵を一身に受けている。

NVIDIAはハードウェアベンダーのポジションに飽き足らず、包括的なシステムを提供するプラットフォームのポジションを模索している。データセンターにおいて機械学習やHPCを必要とする顧客はNVIDIAから一式を受注する用になることが目標だと考えられている。もしかしたら、サブスクリプションで経常収益を得るプランもあるかもしれない。

NVIDIAは、非常に優秀なフリーキャッシュフロー生成によって蓄積した豊富な現金を使い、現代的なデータセンターソリューションパッケージを作るための技術を買い漁るようになった。NVIDIAは2019年にイスラエルのネットワーク新興企業Mellanoxの買収を成功させ、2020年5月にはLinuxベースのネットワークオペレーティングシステムを提供するCumulus Networksを買収した。

NVIDIAはかつてGPUというカテゴリーを生み出したように、今度はDPU(データ処理装置)というカテゴリーを作ろうとしている。このチップはソフトウェア制御が進化している現代のデータセンターにおいてネットワーク・トラフィックの最適化を調整するものだ。MellanoxのSmartNICはネットワークインターフェイスカードにFPGAを追加することで、ネットワークのソフトウェア制御を可能にし、CPUがネットワーク機能を実行するから解放する(詳しくはこちらの記事)。

つまり、NVIDIAは、Nvidia GPU + Arm CPU + Mellanox DPUという組み合わせで、完全なデータセンター・サービスを構築する展望を持っている。この動きはAMDに波及した。AMDのXilinx買収はNVIDIAの構想を追走するものであり、AMD CPU + AMD GPU + Xilinx FPGA + Xilinx SmartNICという、HPCや機械学習ハードウェアのコンペでNVIDIAと競争するための技術スタックを構築するためのものだ。

Graceは、NVIDIAにとってデータセンター用CPU市場への2度目の本格的な挑戦となる。10年以上前に発表されたNVIDIAのProject Denverは、NVIDIAが期待していたような結果にはならなかったが、今回は機械学習に用途が限定されていることから勝算は高い。NVIDIAは、GAFAMのようなクラウドサービスプロバイダを通じてしか利用できないと見られていた技術スタックに手を伸ばす機会を世界中の企業に提供しようとしている。それは非常に貴重な機会ではあるが、決して安くはない。

Special thanks to supporters !

Shogo Otani, 林祐輔, 鈴木卓也, Kinoco, Masatoshi Yokota, Tomochika Hara, 秋元 善次, Satoshi Takeda, Ken Manabe, Yasuhiro Hatabe, 4383, lostworld, ogawaa1218, txpyr12, shimon8470, tokyo_h, kkawakami, nakamatchy, wslash, TS, ikebukurou 黒田太郎, bantou, shota0404, Sarah_investing, Sotaro Kimura, TAMAKI Yoshihito, kanikanaa, La2019, magnettyy, kttshnd, satoshihirose, Tale of orca.

寄付サブスク (吉田を助けろ)

吉田を助けろ(Save the Yoshi!)。運営者の吉田は2年間無休、現在も月8万円の報酬のみでAxionを運営しています。

月10ドル支援したいと考えた人は右上の「Subscribe」のボタンからMonthly 10ドルかYearly 100ドルご支援ください。あるいは、こちらからでも申し込めます。こちらは数量が99個まで設定できるので、大金を助けたい人におすすめです。

その他のサポート

こちらからコーヒー代の支援も可能です。推奨はこちらのStripe Linkです。こちらではない場合は以下からサポートください。

投げ銭