ディープラーニングの炭素排出を縮小する方法

AIの最近の進歩に対する興奮の一部は、警鐘に移っている。昨年の研究では、マサチューセッツ大学アマースト校の研究者が、大規模な深層学習モデルを訓練すると、地球温暖化の原因となる二酸化炭素が62万6000ポンド(約28万キログラム)発生し、これは自動車5台分の生涯排出量に相当すると試算している。

6月にOpenAIは世界最大の言語モデルを発表しました。これは、創造的な小説を書いたり、法律用語を平易な英語に翻訳したり、不明瞭なトリビアの質問に答えたりすることができる、GPT-3と呼ばれるテキスト生成ツールだ。これは、脳内のニューロンが情報を処理して保存する方法を模した機械学習法であるディープラーニングによって達成された知性の最新の偉業である。

モデルが標準的なニューラルネットワークチップ(GPU)で学習されたと仮定すると、少なくとも460万ドルと計算時間355年という高額な代償を払うことになる。このモデルの巨大なサイズ(一般的な言語モデルの1000倍)が、高額なコストの主な要因である。

arXivに公開された論文では、30人以上の共著者からなるチームがモデルといくつかの実験について説明しているが、それまでの自然言語処理の研究では、より大きなモデルが解決策になる可能性があることが示されており、研究チームは以前のモデルであるGPT-2のパラメータを15億個からGPT-3では、1750億個に増やした。GPT-3はいくつかの不備を含みながらもそれを実証した。

パフォーマンスを少しでも向上させるためには、より多くの計算量を投入しなければならず、計算資源が深層学習の制約になっている、というのがMITの研究者であり、ディープラーニングのコンピューティングに対する飽くなき要請を研究してきたニール・トンプソンの主張だ。ディープラーニングをスケーリングするためのより効率的な方法を見つけるか、他の技術を開発しなければならない、とトンプソンは論文に記述している。

AIの最近の進歩に対する興奮の一部は、警鐘に移っている。昨年の研究では、マサチューセッツ大学アマースト校の研究者が、大規模な深層学習モデルを訓練すると、地球温暖化の原因となる二酸化炭素が26万6000ポンド(約1,000万円)発生し、これは自動車5台分の生涯排出量に相当すると試算している。モデルが大型化するにつれ、コンピューティングの需要はハードウェアの効率性の向上を上回るようになっている。GPU(グラフィックス・プロセッシング・ユニット)やTPU(テンソル・プロセッシング・ユニット)のようなニューラル・ネットワーク処理に特化したチップは、より多くのコンピューティングの需要を相殺しているが、十分ではない。

ニューラルネットワークは、1950年代のパーセプトロンという初期の段階から、計算量の限界に悩まされてきた。計算能力が爆発的に向上し、インターネットが大量のデータを放出するようになると、ニューラルネットワークはパターン認識と予測のための強力なエンジンへと進化した。しかし、新しいマイルストーンを迎えるたびに、データを大量に消費するモデルは計算量を増やす必要があるため、コストは爆発的に上昇した。例えば、GPT-3は、5000兆語の単語を使って学習し、モデルを結びつけるための数学的演算や重みである1750億個のパラメータにまで膨れ上がり、わずか1年前の前身のモデルの100倍の大きさになった。

プレプリントサーバarXivに投稿された研究で、トンプソンとその同僚は、ディープラーニングモデルが主要なベンチマークを上回る能力を持つことで、コンピューティングパワーの使用量がほぼ指数関数的に増加していることを示している(AIの炭素排出を追跡しようとしている他の研究者と同様に、チームは報告要件がないため、多くのモデルのエネルギー消費量を推測しなければならなかった)。研究チームは、このままでは、ディープネットとその上で動作するハードウェアが根本的に効率化されない限り、ディープネットは生き残れないと研究者たちは主張している。

よりリーンでグリーンなアルゴリズムを目指して

人間の知覚システムはデータを利用するのに非常に効率的だ。研究者たちは、ビデオや実生活での動作を認識するためにこのアイデアを借りて、モデルをよりコンパクトにしている。8月に開催されたECCV(European Conference on Computer Vision)の論文では、MIT-IBMワトソンAIラボの研究者が、人間と同じように、いくつかの視線から最も関連性の高いデータを選んでシーンを展開する方法を説明している。

サンドイッチを作っている人のビデオクリップを撮るのだが、この論文で概説されている方法では、ポリシーネットワークは、ローストビーフをナイフで切り裂く様子や、パンの上に肉を重ねる様子を高解像度で表現するためのフレームを戦略的に選択する。関連性の低いフレームはスキップされたり、低解像度で表現されたりする。2つ目のモデルでは、CliffsNotesの短縮版を使用して、"making a sandwich" というラベルを付けている。このアプローチにより、次善のモデルの半分の計算コストで、より高速な動画分類が可能になると研究者らは述べている。

補完的なアプローチとして、研究者たちはディープラーニング自体を利用して、ニューラルアーキテクチャ探索として知られる自動化されたプロセスを通じて、より経済的なモデルを設計している。この論文の主著者であるMITの助教授であるSong Hanは、自動検索を使用して、より少ない重みでモデルを設計している。

ECCVで発表された論文の中で、Hanと彼の同僚は、道路標識、歩行者、自転車などの安全上重要な詳細を比較的少ない計算量で見つけることができる3次元シーン認識のためのモデルアーキテクチャを提案している。彼らは進化探索アルゴリズムを使用して1,000のアーキテクチャを評価した後、次の最も優れた方法よりも3倍速く、8倍少ない計算量で使用できるモデルに落ち着いた。

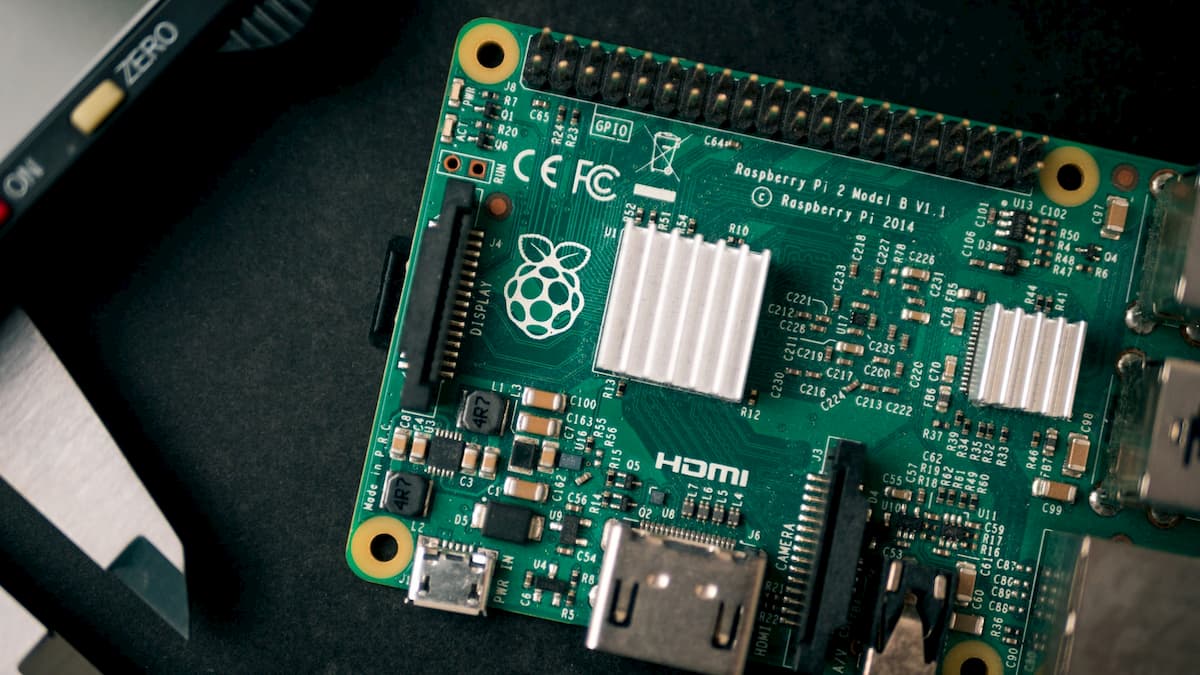

最近の別の論文では、拡張設計された空間内での進化的探索を利用して、GPU、スマートフォン、小型のRaspberry Piなど、特定のデバイス上で機械翻訳を行うための最も効率的なアーキテクチャを見つけ出している。検索と学習プロセスを分離することで、計算量を大幅に削減できるという。

第三のアプローチでは、研究者たちは、上記のような超効率的なネットワークのごく一部を訓練することが可能であるかどうかを確認するために、ディープネットの本質を探っている。提案された「宝くじ仮説」の下で、博士課程の学生ジョナサン・フランクルとMITのマイケル・カービン教授は、それぞれのモデルの中に、10分の1ほどの数の重みで分離して訓練されている可能性がある小さなサブネットワークがあることを提案した。彼らは「勝利のチケット」("winning tickets")と呼んでいる。

彼らは、アルゴリズムが小さな画像分類モデルの中から、これらの勝ち組サブネットワークを遡って見つけることができることを示した。現在、国際機械学習会議(ICML)で発表された論文では、アルゴリズムが大規模モデルでも「勝利のチケット」を見つけることを示している。

2年足らずで、宝くじのアイデアは400回以上引用されている。なぜこのような大規模なネットワークが必要なのかについての標準的な説明は、過剰パラメータ化が学習プロセスを助けるからだ。宝くじの仮説はそれを反証している。もちろん、大きな欠点は、現在のところ、これらの「当選する」出発点を見つけるには、いずれにしてもオーバーパラメタライズされたネットワークを完全に訓練する必要があるということだ。

フランクルは、勝利のチケットを見つける効率的な方法が見つかることを期待しているという。その間に、Morcosが提案するように、勝利のチケットを再利用することで、大きな節約につながる可能性がある。

参考文献

- Neil C. Thompson et al. The Computational Limits of Deep Learning. arXiv. July 10, 2020.

- Haotian Tang et al. Searching Efficient 3D Architectures with Sparse Point-Voxel Convolution. Aug, 2020.

- David R.So et al. The Evolved Transformer. arXiv:1901.11117.

- Hanurui Wang et al. HAT: Hardware-Aware Transformers for Efficient Natural Language Processing. arXiv:2005.14187. [Submitted on 28 May 2020]

- Jonathan Frankle, Michael Carbin. The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks. arXiv:1803.03635. [Submitted on 9 Mar 2018 (v1), last revised 4 Mar 2019 (this version, v5)]

Photo by Marcin Jozwiak on Unsplash